Analyse des Besoins et Évaluation des Performances

Cette page se concentre sur l’identification des besoins en compétences et en formation, ainsi que sur l’évaluation des performances. Les modèles et théories présentés ici (liste non-exhaustive) aident à diagnostiquer les lacunes en matière de compétences et de performances, et à identifier les interventions nécessaires pour y remédier.

Des molèles et théories seront ajoutés continuellement.

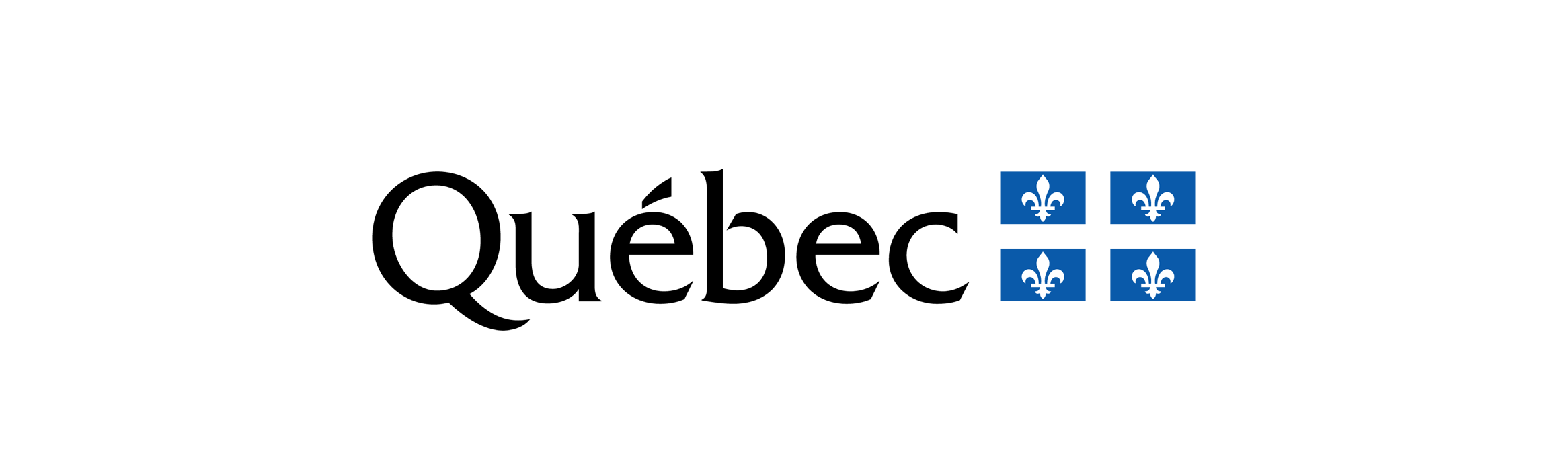

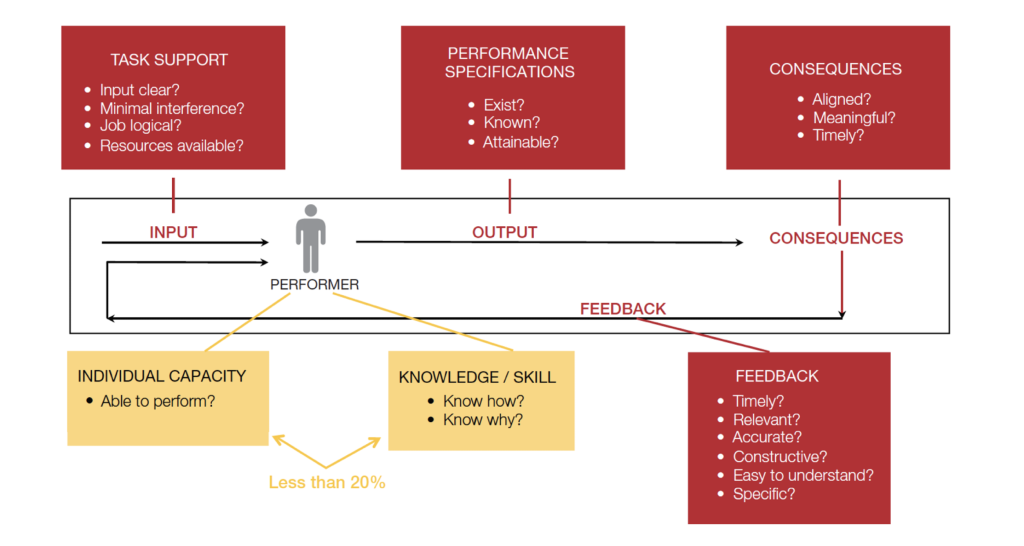

Le modèle de performance de Thomas F. Gilbert, également connu sous le nom de Behavior Engineering Model (BEM), représente une avancée significative dans l’analyse de la performance et la gestion des comportements en milieu professionnel. Développé dans les années 1970, ce modèle différencie les déficiences de performance basées sur des problèmes liés aux ressources, telles que l’environnement de travail, ou sur des facteurs individuels comme la motivation et les compétences.

Gilbert propose que la performance (P) est le produit de l’adéquation entre les compétences (C) et les ressources (R), ainsi que de la motivation (M), formulé comme P = C x R x M. Cela signifie que pour qu’un employé soit performant, il doit non seulement avoir les compétences et la motivation requises, mais il doit également opérer dans un environnement qui soutient et renforce ces éléments.

Le BEM insiste sur le fait que les attentes en matière de performance doivent être clairement définies et que les écarts entre les performances souhaitées et réelles doivent être identifiés. Les facteurs environnementaux, tels que l’équipement, les processus, la structure organisationnelle et les incitations, jouent un rôle fondamental et doivent être analysés pour comprendre et améliorer la formation et le développement des performances.

En milieu professionnel, le BEM suggère que l’amélioration des performances va au-delà de la formation individuelle. Il faut également examiner les contraintes environnementales et organisationnelles qui peuvent limiter la performance. Les interventions devraient inclure la conception de systèmes de travail plus efficaces, la clarification des attentes en matière de performance, et la mise en place d’incitations et de retours pour motiver et soutenir le personnel.

Le BEM favorise une approche holistique et systémique pour résoudre les problèmes de performance. Il soutient qu’une analyse systématique des contraintes est nécessaire pour améliorer les performances. Cette perspective complète souligne l’importance de créer des environnements de travail propices, de fournir des incitations adéquates et de mettre en place des retours d’information efficaces pour soutenir les comportements souhaités.

Ce modèle offre une méthode structurée pour diagnostiquer et résoudre les problèmes de performance, en aidant les personnes professionnels responsables de formation à concevoir des interventions qui traitent à la fois des aspects environnementaux et individuels pour des améliorations durables et efficaces au travail.

Le modèle de Gilbert permette de cibler les interventions là où elles auront l’impact le plus significatif. En se concentrant sur l’analyse des contraintes environnementales et en reconnaissant l’importance des systèmes et des structures, les organisations peuvent réaliser des améliorations significatives dans la performance de leurs employées et employés.

The Behavior Engineering model (BEM) (Gilbert, 1978)

Références

Gilbert, T. F. (1978). Human competence : engineering worthy performance. Mcgraw-Hill.

Human Competence : Engineering worthy performance : Gilbert, Thomas F : Free download, borrow, and streaming : Internet Archive. (1978). Internet Archive. https://archive.org/details/humancompetencee00gilb/page/n7/mode/2up

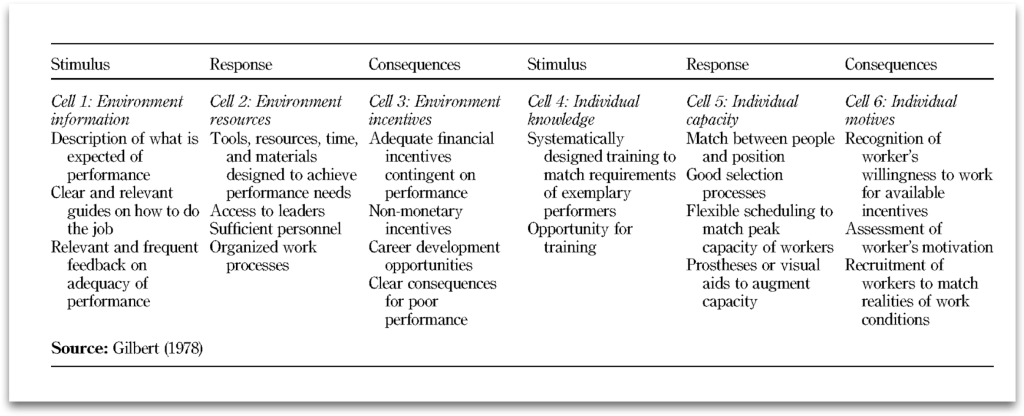

Roger Chevalier a actualisé le modèle de « Behavior Engineering » (BEM) de Thomas Gilbert pour offrir une méthode plus efficace d’identification et de résolution des problèmes de performance au sein des organisations. L’objectif de cette mise à jour était de rendre le modèle plus complet et adaptable, permettant ainsi une application plus large, de l’individu à l’organisation dans son ensemble.

Le modèle mis à jour se divise en deux catégories principales : Environnement et Individu, chacune avec trois sous-catégories :

Environnement

- Information : Assure que les rôles et les attentes de performance des employées et employés sont clairement définis, avec des retours fréquents et pertinents sur leur performance.

- Ressources : Fournit les matériaux, outils, et le temps nécessaires aux employées et employés pour effectuer leur travail, dans un environnement de travail qui favorise la performance, sécuritaire, propre et organisé.

- Incitations : Inclut des incitations financières et non financières, l’enrichissement des postes pour répondre aux besoins des employées et employés, et un environnement de travail global positif offrant des opportunités de développement de carrière.

Individu

- Connaissances / Compétences : S’assure que les employées et employés possèdent les connaissances, l’expérience et les compétences nécessaires pour les comportements souhaités.

- Capacité : Veille à ce que les employées et employés aient la capacité d’apprendre et de réaliser les tâches nécessaires, en adéquation avec le recrutement et la sélection.

- Motifs : Alignement des motivations des employées et employés avec le travail et l’environnement de travail, avec un désir d’accomplir les tâches requises.

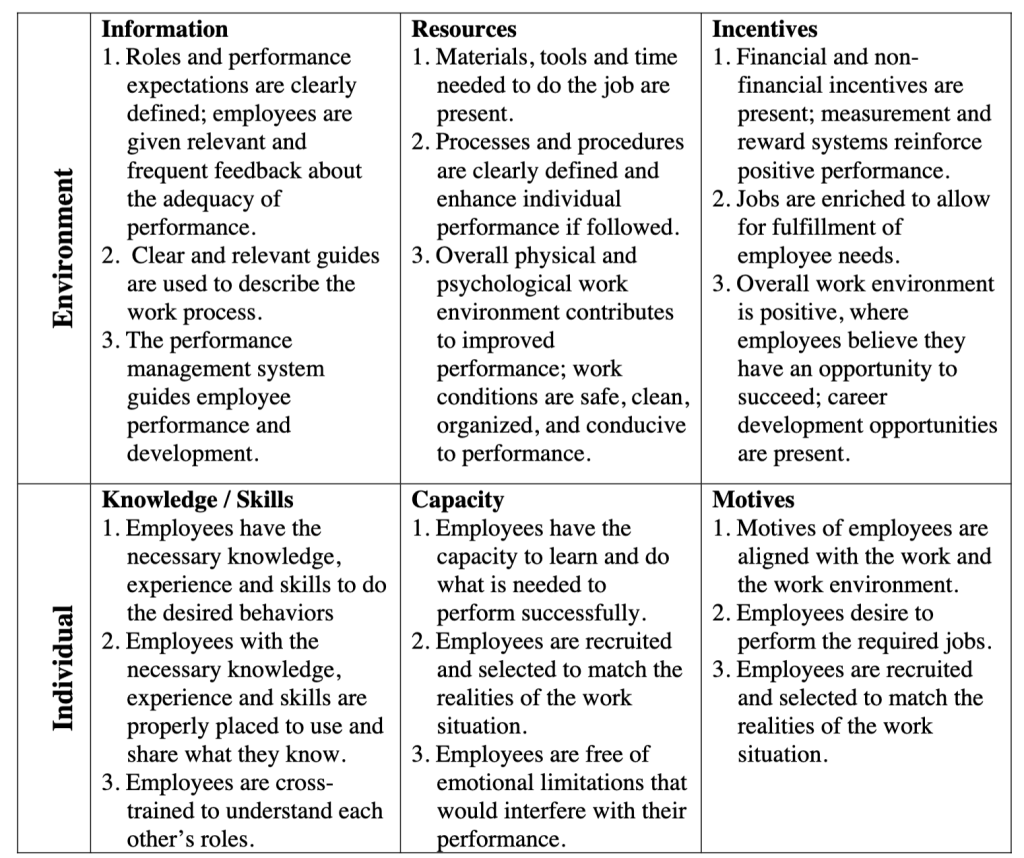

Le modèle mis à jour de Chevalier, tout comme l’original de Gilbert, sert d’outil de diagnostic pour les problèmes de performance, en se concentrant sur la découverte des causes sous-jacentes. L’accent est mis sur l’abordage en premier lieu des facteurs environnementaux, considérés comme les obstacles les plus significatifs à une performance exceptionnelle. Les solutions sont développées en fonction de l’impact potentiel d’un changement et du coût associé à ce changement.

Updated Behavior Engineering Model (Chevalier, 2003, p.3)

Leveraging the Solution (Chevalier, 2003, p.5)

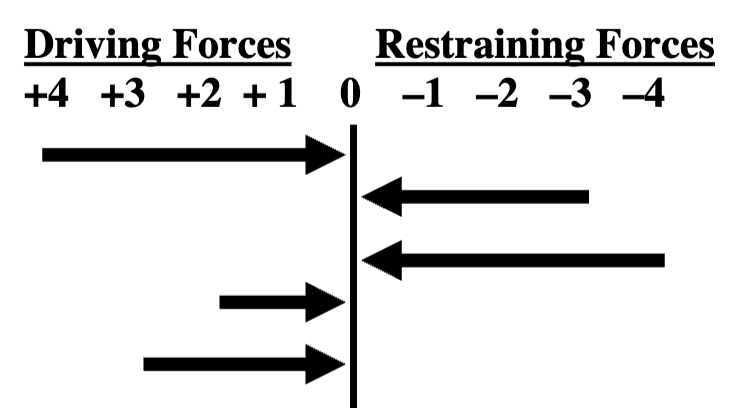

Force Field Analysis (Chevalier, 2003, p.7)

Référence

Chevalier, R. (2003). Updating the behavior engineering model. Performance Improvement, 42(5), 8‑14. https://doi.org/10.1002/pfi.4930420504

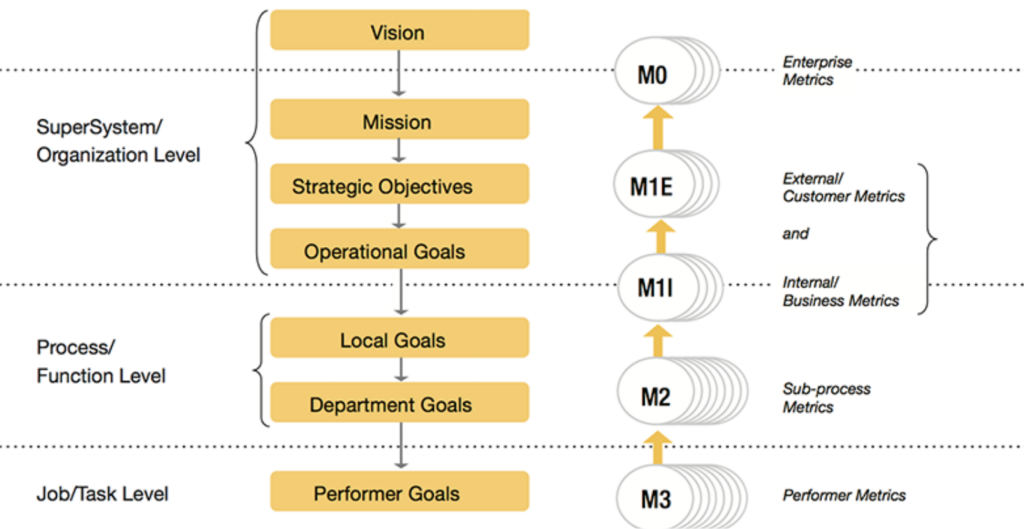

La méthodologie systémique élaborée par Richard Swanson se concentre sur l’amélioration des performances au sein des organisations (R. Swanson, 2007a; 2007b; 2008; 2022; R. A. Swanson, 1999; L. Swanson et al., 2012; L. A. Swanson, 2011). Elle s’appuie sur des principes clés pour évaluer et améliorer efficacement les performances à tous les niveaux de l’organisation, y compris les individus, les processus, les équipes et l’organisation dans son ensemble.

Principes Fondamentaux de l’Analysis for improving performance de Swanson :

- Évaluation Holistique des Performances : L’Analysis for improving performance de Swanson met l’accent sur une évaluation exhaustive des performances, englobant les individus, les équipes, les processus et l’organisation dans son ensemble (Swanson, 2007). Cette analyse globale permet de détecter les besoins à différents niveaux et d’identifier comment des interventions peuvent être les plus bénéfiques.

- Identification des Causes Profondes des Déficits de Performance : Au lieu de se concentrer uniquement sur les symptômes, l’Analysis for improving performance vise à comprendre les causes profondes des déficits de performance. Cela implique d’explorer les facteurs environnementaux et individuels en se penchant les sission/buts, la conception du système, les capacités, les motivations et les expertises qui influencent la performance (Swanson, 1999).

- Interventions Multifactorielles : L’Analysis for improving performance reconnaît que les problèmes de performance peuvent avoir plusieurs causes et promeut donc l’utilisation d’interventions multifactorielles. Ces interventions peuvent inclure des formations, des changements de processus, des améliorations de l’environnement de travail, ou des ajustements des incitatifs (R. Swanson, 2007a).

- Alignement Stratégique des Interventions de Formation : Un élément clé de l’Analysis for improving performance est d’aligner les interventions de formation avec les objectifs stratégiques de l’organisation. Cela garantit que la formation contribue directement aux buts et objectifs globaux de l’entreprise (R. Swanson, 2008).

- Évaluation Continue des Programmes de Formation : L’Analysis for improving performance insiste sur l’importance d’évaluer continuellement les interventions de formation pour ajuster et améliorer les programmes afin qu’ils restent pertinents et efficaces (L. Swanson et al., 2012).

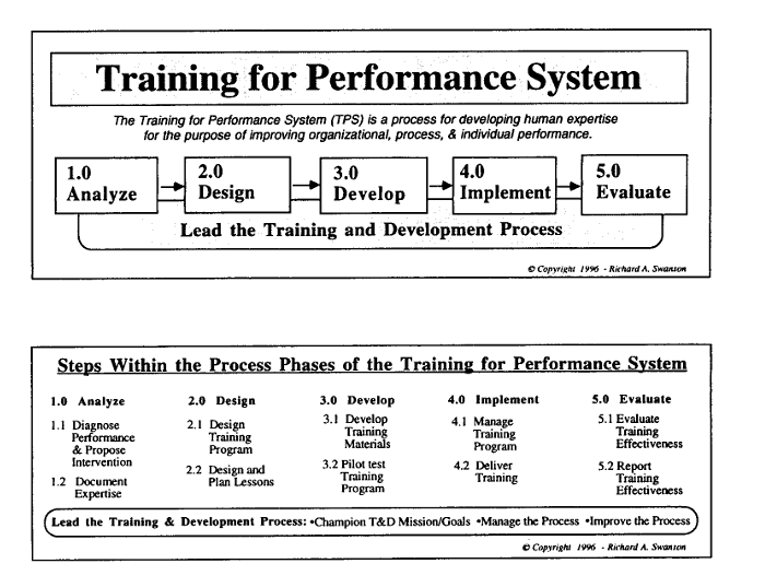

Les 5 étapes de l’Analysis for improving performance (Swanson, 1996)

L’approche de Swanson est particulièrement pertinente pour les personnes professionnelles ayant des responsabilités de formation. Elle permet une compréhension détaillée des exigences de performance et assure que les programmes de formation sont non seulement ciblés mais aussi alignés avec les objectifs globaux de l’organisation (Swanson, 2011). Cette méthodologie contribue à améliorer les compétences individuelles ainsi que la performance globale de l’organisation, en garantissant que les ressources de formation sont utilisées de manière stratégique et efficace.

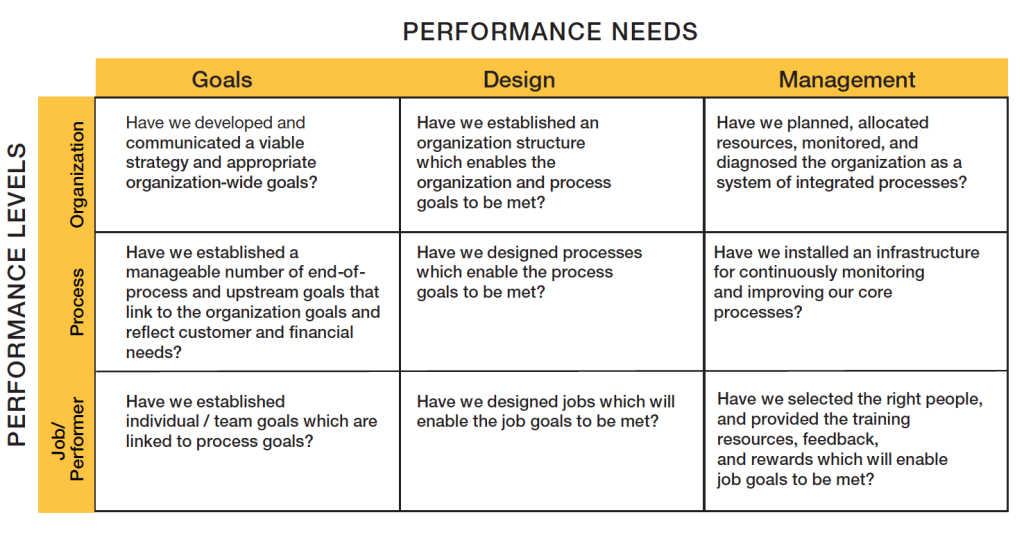

Les variables de performance et les niveaux de performance abordés dans la matrice de diagnostic des performances (PDM) de Swanson (2007)

La matrice de diagnostic des performances (PDM) de Swanson (2007) a été utilisée à l’origine dans le développement des ressources humaines pour identifier les domaines où les performances peuvent être améliorées.

Swanson (2007) définit la performance comme « un résultat productif valorisé d’un système » (traduction libre, p. 27). Une matrice qui examine les variables de performance dans une approche systémique à différents niveaux pourrait générer des questions auxquelles un organisme ne penserait pas autrement.

La matrice de diagnostic des performances (PDM) de Swanson permet aux personnes professionnelles responsables de formation « d’effectuer un diagnostic des performances dans le but d’améliorer les performances de l’organisation » (Swanson 1994, p. 89). Dans la perspective de Ruona et Lyford-Nojima (1997), un diagnostic de performance a deux objectifs. Premièrement, il permet d’identifier l’écart entre les performances réelles et les performances souhaitées. Deuxièmement, il permet de concevoir des interventions qui amélioreront les performances de l’organisation.

Selon Swanson (2007), les problèmes de performance peuvent exister dans une ou plusieurs des cinq variables de performance :

- Mission/buts – l’objectif central vers lequel les efforts sont dirigés

- Conception du système – le plan qui facilite l’interaction entre les éléments interdépendants du système

- Capacité – la possession de moyens ou d’outils nécessaires pour performer

- Motivation – la détermination à atteindre l’objectif de performance

- Expertise – la possession de compétences spécialisées ou de connaissances requises pour effectuer une prestation.

Ces variables sont traitées à quatre niveaux. La liste qui suit juxtapose les niveaux originaux de Swanson à des niveaux renommés aux fins de l’adaptation de la matrice :

- Niveau organisationnel

- Niveau du processus

- Niveau de l’équipe

- Niveau individuel

| Performance Levels/Performance Variables | Organizational Level | Process Level | Team Level | Individual Level |

| Mission/Goal | Do the process goals enable the organization to meet organization and individual missions/goals? | Does the process goals enable the organization to meet organization and individual missions/goals? | Do the team goals provide congruence with the process and individual goals? | Are the professional and personal mission/goals of individuals congruent with the organization’s? |

| System Design | Does the organization system provide structure and policies supporting the desired performance? | Are processes designed in such a way to work as a system? | Do the team dynamics function in such a way to facilitate collaboration and performance? | Does the individual clear obstacles that impede his or her job performance? |

| Capacity | Does the organization have the leadership, capital, and infrastructure to achieve its mission/goals? | Does the process have the capacity to perform (quantity, quality, and timeliness)? | Does the team have the combined capacity to effectively and efficiently meet the performance goals? | Does the individual have the mental, physical, and emotional capacity to perform? |

| Motivation | Do the policies, culture, and reward systems support the desired performance? | Does the process provide information and human factors required to maintain it? | Does the team function in a respectful and supportive manner? | Does the individual want to perform no matter what? |

| Expertise | Does the organization establish and maintain selection and training policies and resources? | Does the process of developing expertise meet the changing demands of changing processes? | Does the team have the team process expertise to perform? | Does the individual have the knowledge and expertise to perform? |

Swanson Performance Diagnosis Matrix for Enabling Questions (2007)

Références et ressources complémentaires

Professor Richard A. Swanson. (s. d.). https://richardswanson.com/index.html

Swanson, L., Jones, E., Riordan, B., Bruni, S., Schurr, N., Sullivan, S., & Lansey, J. (2012). Exploring human error in an RPA target detection task. Proceedings of the Human Factors and Ergonomics Society Annual Meeting, 56(1), 328‑332. https://doi.org/10.1177/1071181312561076

Swanson, R. A. (1996). Analysis for improving performance: Tools for diagnosing organizations and documenting workplace expertise. San Francisco: Berrett-Koehler.

Swanson, R. A. (1999). The Foundations of Performance Improvement and Implications for Practice. Advances in Developing Human Resources, 1(1), 1‑25. https://doi.org/10.1177/152342239900100102

Swanson, R.A. (2007). Analysis for Improving Performance : Tools for Diagnosing Organizations and Documenting Workplace Expertis. San Fransico, CA, Berrett-Koehler Publishers. https://www.bkconnection.com/static/Analysis-For-Improving-Performance_EXCERPT.pdf

Swanson, R. A. (2008). Research and Development (and Other Life and Death Matters). Performance Improvement Quarterly, 1(1), 69‑82. https://doi.org/10.1111/j.1937-8327.1988.tb00008.x

Swanson, R. A. (2011). Response Criterion Placement Modulates the Effects of Graded Alerting Systems on Human Performance and Learning in a Target Detection Task. https://core.ac.uk/download/pdf/4826812.pdf

Swanson, R. A. (2022). Foundations of human resource development. Berrett-Koehler Publishers. https://books.google.com/books?hl=fr&lr=&id=XQI_EAAAQBAJ&oi=fnd&pg=PP1&dq=Analysis+for+Human+Performance+Technology+de+Swanson&ots=T7E9mHVJJW&sig=zhT_SFxXegMW9u6haQPC-gfuTSo

L’Analyse des Besoins de Formation (TNA) est un processus vital pour identifier les besoins de formation organisationnels, largement utilisé dans divers domaines professionnels. Ce concept, ancré dans la gestion des ressources humaines (Bee & Bee, 1994), le commerce (Pearson, 1987), l’industrie (Boydell, 1971), et l’enseignement (Walklin, 1991), sert de première étape dans un processus cyclique contribuant à la stratégie globale de formation et d’éducation du personnel d’une organisation ou d’un groupe professionnel (Gould et al., 2004).

La TNA vise à identifier les écarts entre les compétences, connaissances et comportements actuels des membres du personnel et ceux requis pour atteindre les objectifs organisationnels (Ferdinand, 1988; Gould et al., 2004).

La TNA commence par une compréhension approfondie des objectifs stratégiques de l’organisation et de la contribution des membres du personnel à ces objectifs.

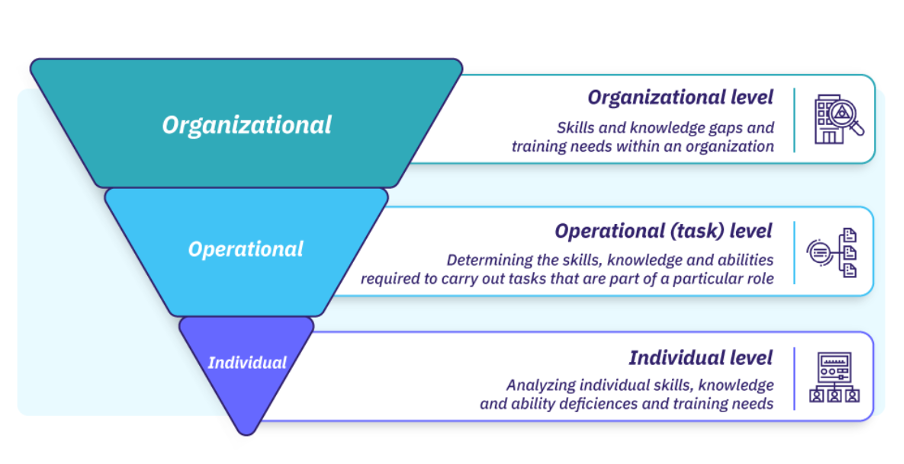

Les niveaux de l’Analyse des Besoins de Formation (Van vulpen, S.D)

La formation ciblée basée sur des objectifs bien spécifiés améliore la productivité d’une organisation (Denby, 2010) et permet ensuite définir et d’évaluer les compétences et connaissances nécessaires pour chaque rôle au sein de cette organisation. Ensuite l’identification des écarts de compétences permet d’identifier si les membres du personel ont besoin de développement. Les besoins de formation identifiés sont priorisés en fonction de leur importance et de leur urgence. Cela aide à allouer les ressources de manière efficace et à mettre en œuvre efficacement des interventions de formation.

La TNA, en tant que processus itératif, est essentielle dans des secteurs dynamiques comme la santé, où elle garantit que la formation reste alignée avec les objectifs changeants de l’organisation et les besoins de développement des membres du personnel (Gould et al., 2004).

Par exemple, une TNA réalisée dans un hôpital peut identifier le besoin de formation continue en soins infirmiers spécialisés, répondant ainsi aux évolutions technologiques et aux nouvelles méthodes de traitement. Une TNA efficace peut identifier le besoin de formation en technologies de l’information pour les spécialistes de santé, en vue d’améliorer la gestion des dossiers patients (Gould et al., 2004). Dans l’industrie, elle peut révéler la nécessité d’une formation en sécurité pour les opérateurs de machines (Boydell, 1971). Dans le domaine de la vente, une TNA peut révéler un besoin de formation en techniques de négociation (Denby, 2010).

L’efficacité de la TNA repose sur sa capacité à s’adapter et à répondre aux changements dans l’environnement organisationnel et professionnel. Ferdinand (1988) souligne l’importance de la TNA dans l’adaptation aux changements technologiques rapides, en particulier dans les industries de pointe. La TNA aide les organisations à rester compétitives en s’assurant que leurs membres du personnel possèdent les compétences et connaissances les plus actuelles.

Références

Bee, F., & Bee, R. (1994). Training Needs Analysis and Evaluation. Institute of Personnel Development. https://www.scirp.org/(S(lz5mqp453edsnp55rrgjct55.))/reference/referencespapers.aspx?referenceid=1687128

Boydell, T. H. (1971). A Guide to the Identification of Training Needs.. BACIE Journal, 25(2), 53‑61. https://eric.ed.gov/?id=ED064614

Denby, S. (2010). The importance of training needs analysis. Industrial and commercial training, 42(3), 147‑150. https://www.researchgate.net/publication/241610493_The_importance_of_training_needs_analysis

Ferdinand, B. (1988). Management training needs analysis (TNA). Industrial and Commercial Training, 20(5), 27‑31. https://www.emerald.com/insight/content/doi/10.1108/eb004113/full/html

Gould, D., Kelly, D., White, I., & Chidgey, J. (2004). Training needs analysis. A literature review and reappraisal. International journal of nursing studies, 41(5), 471‑486. https://pubmed.ncbi.nlm.nih.gov/15120976/

Pearson, G. A. (1987). Business Ethics : Implications for Continuing Education/Staff Development Practice. The Journal of Continuing Education in Nursing, 18(1), 20‑24. https://doi.org/10.3928/0022-0124-19870101-08

Van Vulpen ,E, (S.D). A Guide to Conducting a Training Needs Analysis. https://www.aihr.com/blog/training-needs-analysis/

Walklin, L. (1991). The assessment of performance and competence. Stanley Thornes. https://libcat.kyu.ac.ug/cgi-bin/koha/opac-detail.pl?biblionumber=23969

Le modèle KSA (Knowledge, Skills, and Attitudes) de Watkins, Meiers et Visser est une méthode systématique et approfondie pour évaluer les besoins en formation dans les organisations (Watkins et al., 2012, 2013). Ce modèle est centré sur l’analyse des trois composantes clés : Connaissances, Compétences et Attitudes, reflétant son acronyme « KSA ». L’objectif principal de ce modèle est d’aider les organisations à identifier et à comprendre les lacunes dans ces domaines essentiels qui pourraient être efficacement comblées par des programmes de formation ciblés.

Composantes du Modèle KSA (Watkins et al., 2012, 2013) :

- Connaissances : Cette composante se concentre sur l’information théorique ou factuelle que les membres du personnel doivent maîtriser pour accomplir leurs tâches. L’analyse des connaissances vise à identifier les lacunes spécifiques dans le savoir du personnel, par exemple, une compréhension insuffisante des procédures réglementaires dans un secteur donné. Cette dimension est cruciale pour assurer que les membres du personnel disposent des informations nécessaires pour prendre des décisions éclairées et agir de manière compétente dans leurs rôles respectifs.

- Compétences : Cette composante évalue la capacité pratique d’exécuter des tâches spécifiques. Elle englobe les capacités techniques et interpersonnelles nécessaires pour un rendement optimal, telles que la maîtrise de logiciels spécialisés ou la capacité à gérer efficacement une équipe. La formation axée sur les compétences peut inclure des ateliers pratiques ou des simulations pour développer des compétences spécifiques.

- Attitudes : Cette composante examine la disposition ou la manière d’approcher le travail, y compris la motivation, l’engagement et les perspectives. Elle cherche à comprendre comment les attitudes des personnes employées influencent leur performance et de quelle manière la formation peut contribuer à améliorer ces attitudes. Par exemple, une formation sur la culture d’entreprise ou la sensibilisation à la diversité peut aider à façonner des attitudes positives et constructives au sein de l’organisation.

Le modèle KSA guide les personnes professionnelles ayant des responsabilités de formation dans le processus d’évaluation complète des besoins en formation, en particulier dans le contexte de la santé où il assure l’alignement de la formation avec les objectifs organisationnels et les besoins de développement des membres du personnel (Watkins et al., 2012). Ce modèle permet de développer des stratégies de formation adéquates, répondant précisément aux besoins identifiés.

Références

Watkins, R., West-Meiers, M., & Visser, Y. L. (2012). A guide to assessing needs: Essential tools for collecting information, making decisions, and achieving development results. https://www.academia.edu/28480094/A_guide_to_assessing_needs_essential_tools_for_collecting_information_making_decisions_and_achieving_development_results

Watkins, R., Kaufman, R., & Odunlami, B. (2013). Strategic planning and needs assessment in distance education. Handbook of distance education, 452. https://books.google.com/books?hl=fr&lr=&id=WFH3FBE6aioC&oi=fnd&pg=PA452&dq=Watkins,+Meiers+et+Visser&ots=1oTpFOpieM&sig=CtCKNitKvMcV2dRnrlOr1mVncn4

L’analyse Front-End de Harless est une approche systématique pour évaluer les besoins en formation dans une organisation qui est particulièrement axée sur l’identification des problèmes de performance au sein d’une organisation avant de suggérer des solutions de formation (Flynn, 1990; Glogoff & Flynn, 1990).

Ce modèle est structuré autour de quatre étapes clés :

- Identification des Problèmes de Performance : La première étape implique d’identifier clairement les problèmes de performance ou les opportunités d’amélioration. Cette phase est cruciale pour déterminer si les difficultés rencontrées sont dues à un manque de compétences ou de connaissances chez les membres du personnel, ou à d’autres facteurs organisationnels (Flynn & Glogoff, 1990).

- Diagnostic des Causes Sous-Jacentes : Après avoir identifié les problèmes, l’analyse Front-End se concentre sur le diagnostic des causes sous-jacentes. Il s’agit d’analyser en profondeur les raisons derrière les problèmes de performance pour identifier si une formation ou d’autres types d’interventions sont nécessaires (Glogoff & Flynn, 1990).

- Identification des Solutions Possibles : Cette étape consiste à envisager diverses solutions basées sur les résultats du diagnostic. Cela peut inclure des formations spécifiques pour combler les lacunes en compétences, des améliorations dans l’environnement de travail, ou des mises à jour technologiques (Glogoff & Flynn, 1990).

- Évaluation des Coûts et Avantages : Enfin, l’analyse Front-End nécessite une évaluation des coûts et des avantages de chaque intervention potentielle. Cela permet de déterminer quelles solutions offrent le meilleur retour sur investissement et sont donc les plus appropriées pour l’organisation (Glogoff & Flynn, 1990).

L’analyse de Harless permet aux personnes professionnelles ayant des responsabilités de formation de développer et mettre en œuvre un développement du matériel de formation répondant aux performances. C’est une approche qui assure que les ressources de formation sont utilisées de manière à maximiser l’efficacité organisationnelle et à répondre aux besoins spécifiques en matière de performance.

Références

Flynn, S. J. G. J., James P. (1990). Front-End Analysis : Aligning Library Planning, Resources, and Commitment to ILS Staff Training. In Training Issues and Strategies in Libraries. Routledge. https://www.taylorfrancis.com/chapters/edit/10.4324/9780367821562-3/front-end-analysis-aligning-library-planning-resources-commitment-ils-staff-training-stuart-glogoff-james-james-flynn

Glogoff, S., & Flynn, J. P. (1990). Front-End Analysis. Journal of Library Administration, 12(2), 13‑26. https://doi.org/10.1300/J111v12n02_03

L’analyse de tâche (Task Analysis) de Jonassen représente une méthode d’analyse des besoins en formation centrée sur l’examen minutieux des tâches nécessaires à l’exécution d’un travail ou d’une activité spécifique. Cette approche méthodique, élaborée par David H. Jonassen, est fondamentale dans le développement de programmes de formation adaptés et efficaces (Jonassen & Hannum, 1986; Jonassen et al., 1989, 1998; Hannum, 1998).

Les étapes du Processus de l’Analyse de Tâche :

- Identification des Tâches et Objectifs : La première étape consiste à identifier les tâches à accomplir et les objectifs associés (Jonassen & Hannum, 1986). Cette phase permet de cerner précisément les exigences du rôle ou de l’activité concernée.

- Décomposition en Sous-Tâches : Les tâches identifiées sont ensuite décomposées en sous-tâches ou étapes gérables (Hannum, 1998). Cette segmentation facilite l’analyse détaillée des compétences spécifiques requises pour chaque sous-tâche.

- Identification des Compétences Requises : L’étape suivante implique de déterminer les connaissances, compétences et attitudes nécessaires pour réaliser chaque sous-tâche (Jonassen, Hannum & Tessmer, 1989). Cette analyse permet d’identifier les lacunes en compétences et de cibler les domaines nécessitant une formation.

- Analyse des Écarts de Performance : Cette phase évalue les écarts entre la performance actuelle et la performance souhaitée (Jonassen et al., 1998). Elle aide à déterminer les besoins spécifiques en formation où les membres du personnel actuels ne répondent pas aux exigences de la tâche.

- Conception de Programmes de Formation : Sur la base des informations recueillies, un programme de formation est élaboré pour combler les écarts identifiés (Hannum, 1998). Ce programme est spécialement adapté pour développer les compétences, connaissances et attitudes nécessaires identifiées lors de l’analyse.

- Évaluation des Résultats de la Formation : Finalement, une évaluation est effectuée pour vérifier si les écarts de performance ont été comblés et si les objectifs de formation ont été atteints (Jonassen et al., 1998).

Cette approche est particulièrement cruciale dans le domaine de la formation professionnelle, offrant une méthodologie détaillée et structurée pour identifier et répondre précisément aux besoins de formation (Jonassen, Tessmer & Hannum, 1998). Cette méthodologie est reconnue pour son efficacité dans la conception de programmes de formation adaptés, rendant les processus d’apprentissage plus ciblés et donc plus efficaces (Hannum, 1998a; 1998b).

Dans des environnements complexes comme les structures sanitaires, le modèle d’analyse de tâche de Jonassen permet aux personnes professionnelles ayant des responsabilités de formation de comprendre en profondeur les exigences de performance spécifiques à chaque rôle. En décomposant méticuleusement chaque tâche et en identifiant les compétences, connaissances et attitudes nécessaires, les programmes de formation peuvent être conçus pour combler les lacunes spécifiques, assurant ainsi que le personnel est équipé pour répondre efficacement aux défis de leur poste (Jonassen & Hannum, 1986).

Cette approche est également bénéfique pour l’alignement stratégique des objectifs de formation avec les objectifs globaux de l’organisation. En analysant les tâches à un niveau granulaire, les corps formateur et gestionnaire peuvent mieux comprendre comment chaque rôle contribue aux objectifs de l’organisation et peuvent ainsi élaborer des programmes de formation qui soutiennent non seulement le développement individuel, mais aussi la réalisation des objectifs organisationnels (Jonassen, Hannum & Tessmer, 1989).

De plus, l’analyse de tâche de Jonassen favorise une approche de formation basée sur les preuves, où les décisions concernant le développement de programmes de formation sont fondées sur des données concrètes plutôt que sur des suppositions. Cette méthodologie assure que les investissements en formation sont justifiés et alignés sur les besoins réels, augmentant ainsi le retour sur investissement des programmes de formation (Hannum, 1998).

Références

Hannum, D. H. J., Martin Tessmer, Wallace H. (1998). What is Task Analysis? Task Analysis Methods for Instructional Design. Routledge. https://doi.org/10.4324/9781410602657.

Jonassen, D. H., & Hannum, W. H. (1986). Analysis of task analysis procedures. Journal of Instructional Development, 9(2), 2‑12. https://doi.org/10.1007/BF02905208

Jonassen, D. H., Hannum, W. H., & Tessmer, M. (1989). Handbook of task analysis procedures (p. xiv, 408). Praeger Publishers.

Jonassen, D. H., Tessmer, M., & Hannum, W. H. (1998). Task Analysis Methods for Instructional Design. Routledge. https://lms.ptuk.edu.ps/pluginfile.php/1875/mod_resource/content/0/TASK%20ANALYSIS%20METHODS%20FOR%20ID.pdf

L’évaluation des besoins en formation selon la méthode de Rossett est un processus systématique visant à identifier et analyser les lacunes en termes de compétences et connaissances au sein d’une organization (Rossett, 1982, 1987, 1990, 1995). Cette évaluation se repose sur l’identification et l’analyses des performances attendues, l’ientification des causes des écarts de performances et la mise en place de solutions.

L’évaluation des besoins (Rossett, 1991, p.157)

Étapes Détaillées de l’Évaluation des Besoins selon Rossett :

- Identification des Besoins : Cette étape consiste à définir clairement les compétences et les connaissances que les membres du personnel devraient maîtriser après la formation. Elle implique une compréhension approfondie des objectifs de l’entreprise et du rôle des membres du personnel dans la réalisation de ces objectifs. Cette phase est cruciale pour s’assurer que les efforts de formation sont alignés avec les besoins stratégiques de l’organisation (Rossett, 1995).

- Analyse des Performances : L’étape suivante implique d’évaluer les performances actuelles des membres du personnel pour identifier les écarts par rapport aux performances attendues. Les outils utilisés pour cette analyse peuvent inclure des évaluations de performance, des enquêtes, des entretiens, et d’autres méthodes d’évaluation. Cette analyse permet de cibler les domaines spécifiques où la formation est nécessaire (Rossett, 1987).

- Compréhension des Causes des Écarts : Une fois les écarts identifiés, il est essentiel de comprendre les raisons sous-jacentes de leur existence. Cela peut inclure des lacunes en compétences, connaissances, ressources ou motivation. Rossett recommande d’examiner les solutions de formation et les solutions non liées à la formation pour combler ces écarts, en envisageant des approches complémentaires telles que des modifications de l’environnement de travail ou des incitations (Rossett, 1990).

- Développement d’un Plan d’Action : Cette phase implique la création d’un plan détaillé pour mettre en œuvre les solutions identifiées. Le plan doit inclure les ressources nécessaires, les calendriers, et les responsabilités, assurant ainsi une mise en œuvre efficace des interventions de formation (Rossett, 1982).

- Évaluation de l’Efficacité de la Formation : La dernière étape est l’évaluation de l’efficacité de la formation. Cela implique de vérifier si les écarts de performance ont été comblés et si les objectifs de formation ont été atteints, garantissant ainsi que les interventions de formation ont réellement amélioré les performances (Rossett, 1987).

L’évaluation des besoins en formation selon Rossett est un processus détaillé et ciblé qui aide les personnes responsables de la formation professionnelle à aligner efficacement les efforts de formation avec les besoins spécifiques du personnel. Cette méthodologie permet de s’assurer que les interventions de formation contribuent de manière significative à l’amélioration des performances globales de l’organisation.

Références

Rossett, A. (1982). A typology for generating needs assessments. Journal of Instructional Development, 6(1), 28‑33. https://link.springer.com/article/10.1007/BF02905113

Rossett, A. (1987). Training needs assessment. Educational Technology. https://books.google.com/books?hl=fr&lr=&id=IWBppwNMC-QC&oi=fnd&pg=PR7&dq=Needs+Assessment+de+Rossett+&ots=PayVIHckL_&sig=NuE2p513pEs1-hfcEfeIpi9Ypkw

Rossett, A. (1990). Overcoming obstacles to needs assessment. Training: the Magazine of Human Resources Development, 27(3), 36‑42. https://eric.ed.gov/?id=EJ403447

Rossett, A. (1991). Needs assessment. Instructional technology: Past, present, and future, 156‑169. https://gwern.net/doc/psychology/1991-anglin-instructionaltechnology.pdf

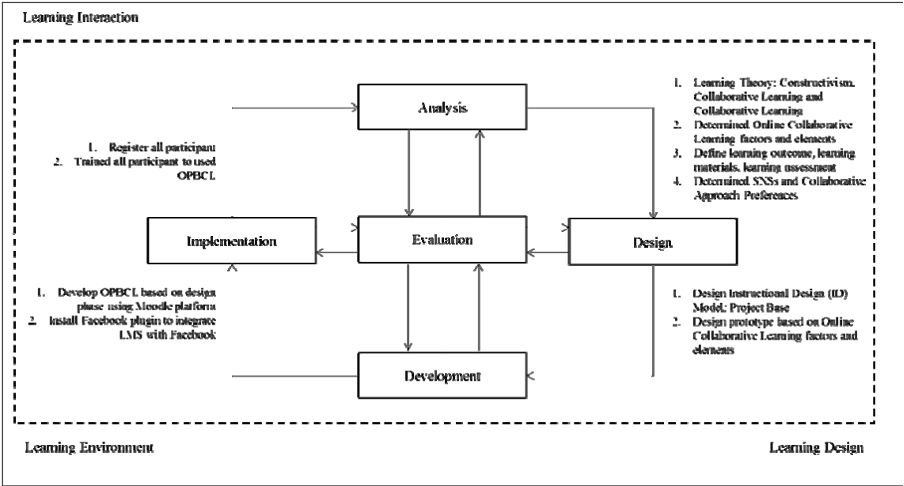

Le modèle ADDIE, un cadre méthodologique classique dans le domaine de la conception pédagogique et de la formation, se distingue par ses cinq phases distinctes : Analyse, Design (Conception), Développement, Implémentation et Évaluation (Muruganantham, 2015; Nadiyah & Faaizah, 2015; Widyastuti, 2019). Chaque phase joue un rôle crucial dans la création et la mise en œuvre de programmes de formation efficaces.

Les étapes du Modèle ADDIE (Nadiyah, R. S., & Faaizah, S., 2015, p. 1806)

Étapes Approfondies du Modèle ADDIE

- Analyse : La phase d’analyse est fondamentale pour la réussite du processus de conception pédagogique. Elle implique de définir le problème, d’identifier la source du problème et de déterminer les solutions possibles (Muruganantham, 2015). Cette étape comprend des recherches spécifiques, l’analyse des besoins, des objectifs et des tâches. Elle est essentielle pour comprendre le contexte d’apprentissage et les besoins des personnes apprenantes.

- Conception : La phase de conception utilise les résultats de l’analyse pour planifier une stratégie d’élaboration de l’enseignement. Lors de cette étape, les objectifs pédagogiques sont définis et les bases pédagogiques sont élargies, en préparant le terrain pour le développement des contenus et des activités d’apprentissage (Nadiyah & Faaizah, 2015).

- Développement : Cette phase vise à créer les plans de cours et les matériaux de formation. Elle implique le développement de supports pédagogiques en utilisant des logiciels multimédias et de la documentation à l’appui (Moradmand et al., 2014). C’est une étape clé pour transformer les objectifs pédagogiques en ressources d’apprentissage concrètes.

- Implémentation : La phase de mise en œuvre concerne la livraison effective de la formation, qu’elle soit en classe, en laboratoire ou en ligne. L’objectif est de fournir un enseignement objectif, efficace et efficient (Widyastuti, 2019).

- Évaluation : La phase finale d’évaluation mesure l’efficacité et l’efficience de l’instruction. L’évaluation se déroule tout au long du processus de conception, entre les phases et après la mise en œuvre. Son objectif est d’améliorer la conception avant la mise en œuvre finale de la formation (Moradmand et al., 2014).

Le modèle ADDIE, avec ses phases d’Analyse, Design, Développement, Implémentation et Évaluation, est un outil polyvalent et essentiel dans de nombreux domaines professionnels. Il offre une structure claire pour la création de programmes de formation adaptés et efficaces, quelle que soit l’industrie. Le modèle ADDIE est d’une importance capitale pour les personnes professionnelles ayant des responsabilités de formation. Il offre une approche systématique et exhaustive pour concevoir et mettre en place des programmes de formation, assurant que les besoins spécifiques du personnel sont pris en compte.

Par exemple dans le secteur technologique, pour la formation du personnel en charge du développement de logiciels sur un nouveau langage de programmation, la phase d’analyse pourrait révéler le besoin d’acquérir des compétences spécifiques dans ce langage. La conception se concentrerait sur des modules enseignant les aspects fondamentaux et avancés du langage. Pendant le développement, des exercices pratiques et des projets seraient créés. L’implémentation impliquerait des sessions de formation interactive, et l’évaluation mesurerait la compétence du personnel de développement dans le nouveau langage.

Dans le Management, pour une formation en leadership destinée aux cadres de moyenne gestion, l’analyse identifierait des compétences clés comme la communication efficace et la gestion des conflits. La conception élaborerait un curriculum axé sur ces compétences. Le développement produirait des études de cas et des scénarios interactifs. L’implémentation inclurait des sessions de formation en groupe et des simulations, tandis que l’évaluation mesurerait l’amélioration des compétences de gestion.

Bien qu’il soit souvent décrit comme linéaire, mais dans la pratique, le modèle ADDIE est itératif, permettant aux conceptices et concepteurs de revenir en arrière et de réviser les étapes précédentes en fonction des résultats de l’évaluation.

(Obsidian Learning, 2018)

Références et ressources complémentaires

Branch, R. M. (2009). Instructional Design : the ADDIE approach. Dans Springer eBooks. https://doi.org/10.1007/978-0-387-09506-6

Moradmand, N., Datta, A., & Oakley, G. (2014). The design and implementation of an educational multimedia mathematics software: Using ADDIE to guide instructional system design. The Journal of Applied Instructional Design, 4(1), 37‑49. https://www.semanticscholar.org/paper/The-Design-and-Implementation-of-an-Educational-to-Moradmand-Datta/082df7721612aeab36291b0928fabf8091b87dd5

Muruganantham, G. (2015). Developing of E-content package by using ADDIE model. https://www.allresearchjournal.com/archives/?year=2015&vol=1&issue=3&part=B&ArticleId=66

Nadiyah, R. S., & Faaizah, S. (2015). The development of online project based collaborative learning using ADDIE model. Procedia-Social and Behavioral Sciences, 195, 1803‑1812. https://www.sciencedirect.com/science/article/pii/S1877042815038719

Obsidian Learning. (2018, 16 octobre). ADDIE model. https://obsidianlearning.com/projects/addie-model/

Widyastuti, E. (2019). Using the ADDIE model to develop learning material for actuarial mathematics. Journal of Physics: Conference Series, 1188(1), 012052. https://iopscience.iop.org/article/10.1088/1742-6596/1188/1/012052/meta

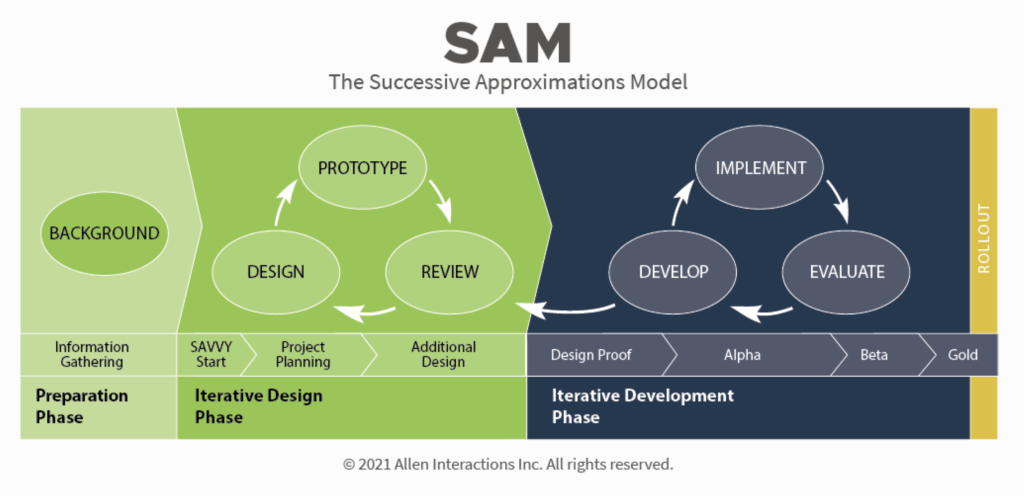

Le modèle SAM (Successive Approximation Model) ou modèle d’itérations successives est une approche de conception pédagogique qui favorise un développement agile, rapide et itératif des solutions d’apprentissage. Contrairement à l’approche linéaire et séquentielle de ADDIE, SAM encourage la collaboration et l’ajustement réactif aux retours des groupes utilisateurs et des parties impliquées, ce qui est particulièrement pertinent dans des environnements en évolution rapide où les besoins de formation peuvent changer rapidement (Allen et Sites, 2012).

Cette approche itérative permet aux personnes chargées de la conception d’apprentissage de tester et d’améliorer continuellement leurs conceptions, garantissant ainsi que le produit final est à la fois efficace et adapté aux besoins des personnes apprenantes. La flexibilité du modèle SAM le rend particulièrement adapté pour intégrer de nouvelles technologies et approches pédagogiques, ce qui le rend idéal pour des contextes de formation dynamique et en constante évolution.

Voici les principales caractéristiques du modèle SAM :

- Approche itérative : SAM utilise des cycles d’itérations successives pour affiner et améliorer continuellement les solutions d’apprentissage. Cette méthode itérative favorise l’innovation et l’ajustement en temps réel, chose essentiel en environnement d’apprentissage.

- Développement rapide : En mettant l’accent sur la création rapide de prototypes, SAM accélère le processus de test et d’ajustement des solutions d’apprentissage. Cette rapidité permet une réponse plus efficace des besoins en perpétuelle évolution des personnes apprenantes et du marché.

- Collaboration : Le modèle encourage la collaboration étroite entre les personnes chargées de la conception pédagogique, les personnes expertes du domaine et l’ensemble des parties prenantes tout au long du processus de conception. Cette approche collaborative assure que les différentes perspectives sont prises en compte et que le produit final répond aux besoins de tous les groupes utilisateurs.

- Flexibilité : SAM est conçu pour être flexible et réactif et peut s’adapter facilement aux changements de besoins ou aux contraintes de projet qui peuvent survenir. Cette flexibilité rend le modèle particulièrement adapté aux projets ou les exigences peuvent évoluer rapidement.

- Évaluation continue : L’intégration de l’évaluation et la rétroaction à chaque étape du processus, permet des ajustements rapides et pertinents. Cela garantit que le produit final est de haute qualité et répond aux besoins des personnes apprenantes.

Le modèle SAM est divisé en trois phases principales (Allen, 2021) :

(Allen Interactions Inc., s. d.)

- Phase de préparation : cette phase initiale comprend l’analyse des besoins, la définition des objectifs d’apprentissage et la planification initiale du projet. Cela permet de s’assurer que le projet d’apprentissage est aligné avec les objectifs globaux et répond aux exigences des personnes apprenantes.

- Phase de conception itérative : cette phase clé inclut la création de prototypes, les tests et les révisions basées sur la rétroaction. Elle permet d’identifier rapidement les problèmes et d’apporter les modifications nécessaires, cela, garantit des solutions d’apprentissage efficaces et adaptées.

- Phase de développement itératif : cette phase se concentre sur le développement final des solutions d’apprentissage, les tests d’utilisabilité et l’implémentation. Elle permet de peaufiner le produit d’apprentissage et de s’assurer qu’il répond aux normes de qualité et aux besoins des utilisateurs finaux.

Le modèle SAM est particulièrement utile pour les projets qui nécessitent une réponse rapide et une capacité à s’adapter aux changements, tout en impliquant activement les parties prenantes dans le processus de conception (Rimmer, 2016).

Le modèle SAM a des implications significatives dans la formation et l’apprentissage en milieu professionnel. Il favorise une conception agile et flexible, permettant des ajustements continus et une collaboration étroite avec les experts métier. Cette méthode réduit les cycles de développement et améliore la communication entre les parties prenantes, ce qui est crucial pour répondre rapidement aux besoins changeants des entreprises et des personnes apprenantes.

En pratique, SAM implique la création de prototypes et la réalisation d’itérations successives pour affiner les solutions d’apprentissage (Allen, 2021). Cela permet de tester et d’améliorer les dispositifs de formation dès les premières phases de conception, assurant ainsi que le produit final est efficace et pertinent.

Références et ressources complémentaires

Allen Interactions Inc. (s. d.). SAM (The Successive Approximations Model) for eLearning Development | Allen Interactions | Custom Learning Solutions. https://www.alleninteractions.com/services/custom-learning/sam/elearning-development

Allen, M. (2012). Leaving ADDIE for SAM : An Agile model for Developing Best Learning Experiences. Google Books. Consulté le 16 décembre 2023, à l’adresse https://www.google.ca/books/edition/Leaving_ADDIE_for_SAM/DSQBJOt2_0cC?hl=fr&gbpv=1&dq=Leaving+Addie+for+SAM&printsec=frontcover

Rimmer, T. (2021). An introduction to SAM for instructional designers – E-Learning Heroes. E-Learning Heroes. https://community.articulate.com/series/trina-s-articles/articles/an-introduction-to-sam-for-instructional-designers

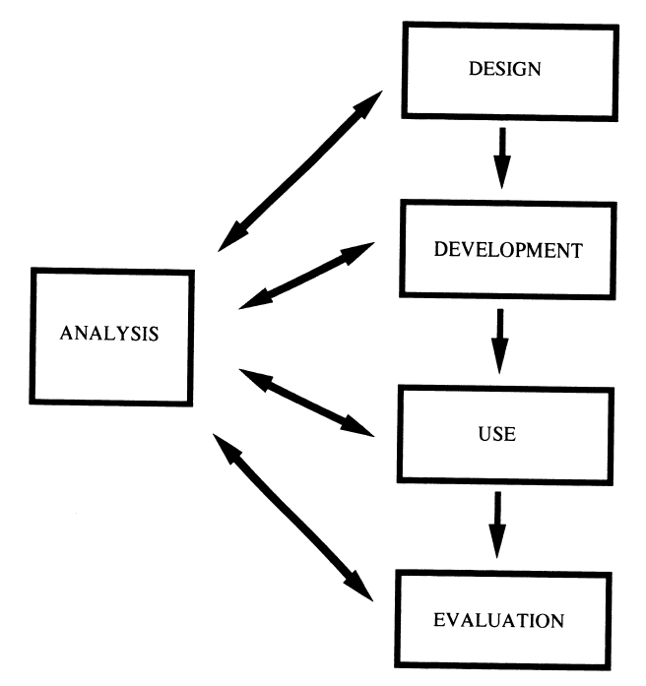

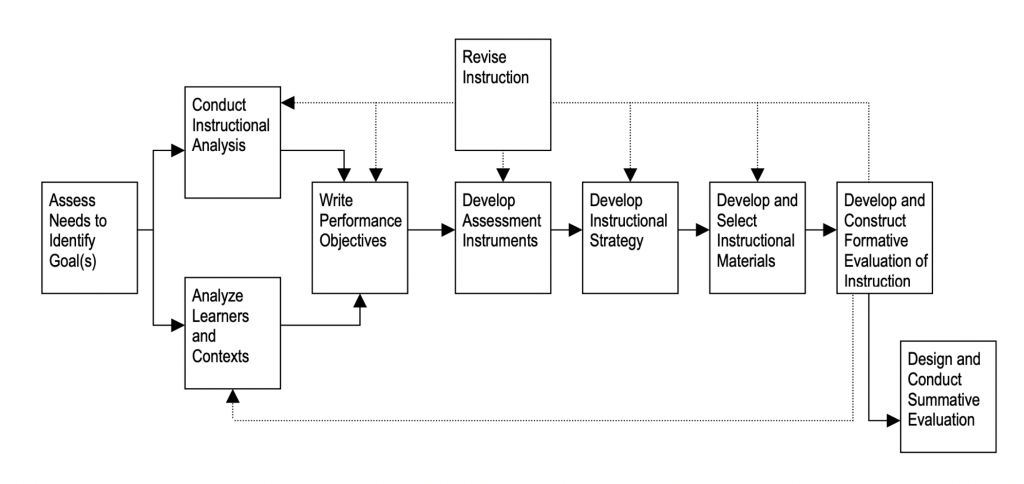

Proposé en 1978 par Walter Dick et Lou Carey, ce modèle met l’accent sur les relations entre les éléments du processus de conception.

(Dick et Carey, 1978)

L’application du modèle Dick et Carey en milieu professionnel offre une approche systématique et structurée de la conception d’une formation, en s’assurant que chaque aspect est méticuleusement planifié et aligné avec les objectifs d’apprentissage. Le modèle encourage également une évaluation continue et la révision des matériaux d’instruction, ce qui est essentiel pour assurer la pertinence et l’efficacité de la formation dans un paysage professionnel en constante évolution.

Références et ressources complémentaires

Dick, W., & Carey, J. (1978). The systematic design of instruction. Consulté le 16 décembre 2023, à l’adresse https://www.semanticscholar.org/paper/The-systematic-design-of-instruction-Dick-Carey/bdee2e8dde217c6a420adf2c90358e1294f2559e

Dick, W., & Carey, L. (2021, 9 mars). Systematic design of instruction, the 9th edition. Pearson. https://www.pearson.com/en-ca/subject-catalog/p/systematic-design-of-instruction-the/P200000000952/9780137510344

The Systematic Design of Instruction : Dick, Walter, 1937- : Free download, borrow, and streaming : Internet Archive. (1996). Internet Archive. https://archive.org/details/systematicdesign0004dick

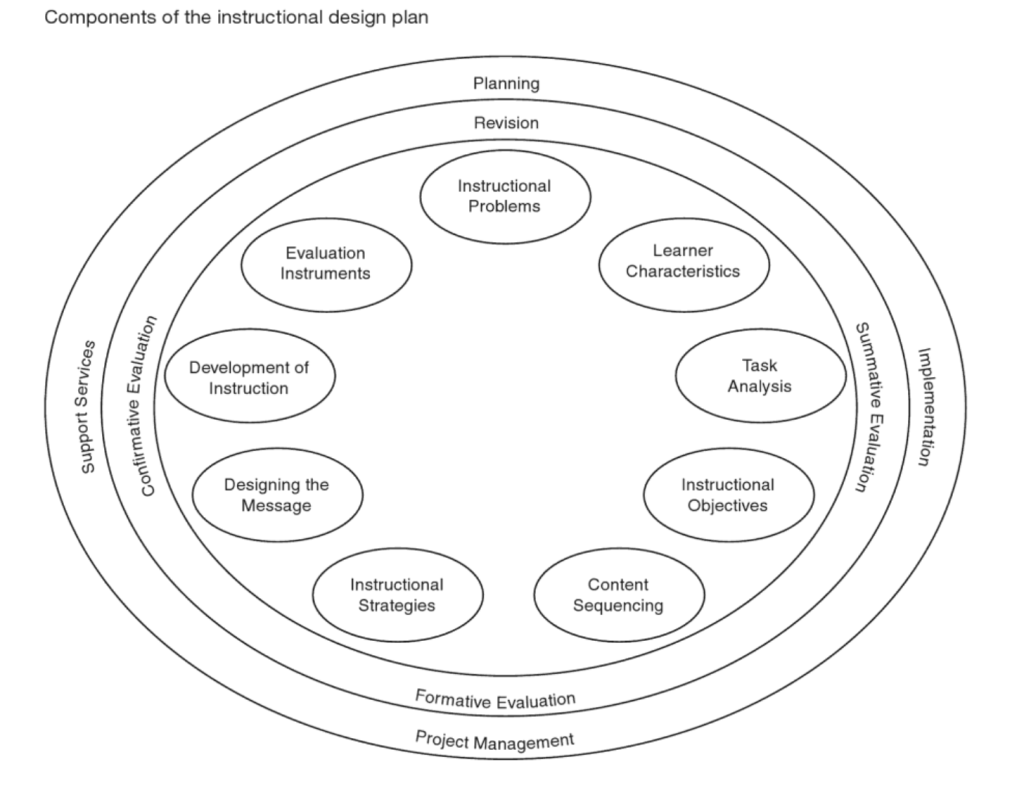

Le modèle Kemp, aussi connu sous le nom de modèle Morrison, Ross et Kemp, se focalise sur quatre éléments clés dans le développement de cours : personnes étudiantes, objectifs, méthodes, et évaluation. Ce modèle, non linéaire et flexible, considère la conception pédagogique comme un cycle continu de révision et d’ajustement. Il comprend neuf étapes, pouvant être abordées de façon simultanée, individuelle ou parfois pas du tout, et encourage à prendre en compte les besoins des apprenants dans la création du matériel de cours et des évaluations.

(Morrison et al., 2011)

Références et ressources complémentaires

Instructional Designers of Penn State. (s. d.). Kemp model of design. Pressbooks. https://psu.pb.unizin.org/idhandbook/chapter/kemp/

Morrison, G. R., Ross, S. M., Kalman, H., & Kemp, J. E. (2011). Designing Effective Instruction (6e éd.). John Wiley & Sons. https://books.google.com.tj/books?id=ygIbaClN3KMC&printsec=frontcover#v=onepage&q&f=false

La théorie des objectifs pédagogiques de Robert F. Mager souligne l’importance de définir clairement les résultats d’apprentissage attendus. Mager insiste sur l’identification précise des comportements attendus, des conditions d’apprentissage nécessaires, et des critères de performance. Il met en avant la résolution de problèmes comme compétence clé et préconise une approche systématique pour définir des objectifs pédagogiques clairs, pertinents et immédiatement transférables, surtout en milieu professionnel.

Cette méthode favorise l’évaluation efficace des programmes de formation en se focalisant sur des résultats observables et mesurables, et encourage la décomposition des problèmes en éléments spécifiques pour une formation ciblée et efficace.

Anatomie d’un objectif d’Apprentissage : Action + Condition + Critères

Alors qu’un objectif peut contenir plusieurs conditions et critères, il est primordial qu’il soit limité à un seul verbe d’action, mesurable et observable.

Références

Mager, R. F. (1962). Comment définir des objectifs pédagogiques. Paris, Gauthier-Villars. https://www.dunod.com/sciences-humaines-et-sociales/comment-definir-objectifs-pedagogiques-0

Mager, R. M. (1975). Preparing instructional objectives. Palo Alto, CA: Fearon Publishiners. https://babel.hathitrust.org/cgi/pt?id=mdp.39015020958941&seq=5

Les évaluations formatives et sommatives des programmes de formation : (En construction)

« Quand un chef goûte la soupe, c’est une évaluation formative, mais quand le client la goûte, c’est une évaluation sommative » (Robert Stake)

Programme de formation Types d’évaluation | Quoi | Quand | Comment |

| Évaluation formative | Évaluer la probabilité qu’un programme en cours de développement atteigne les objectifs visés | Au cours du développement | Technique (expert en la matière) Éditorial Test pilote/utilisation |

| Évaluation sommative | Évaluer la mesure dans laquelle un programme en cours d’utilisation a atteint les objectifs visés | Après l’implantation du programme | Kirkpatrick, Philipps, Kaufman, LTEM et autres |

Les évaluations formatives et sommatives des apprentissages :

Les évaluations formatives sont orientées vers l’amélioration continue du processus d’apprentissage. Elles sont intégrées tout au long de l’intervention d’apprentissage pour permettre des ajustements en fonction des besoins et de la progression des personnes apprenantes. Ces évaluations favorisent également l’engagement actif de ces personnes apprenants dans leur propre processus d’apprentissage, leur permettant de comprendre leurs propres forces et faiblesses.

Les évaluations sommatives, effectuées à la fin d’une unité d’enseignement ou d’un programme, ont pour but de mesurer le niveau de compétence ou de compréhension atteint par les personnes apprenantes. Ces évaluations sont souvent plus formelles que les évaluations formatives et peuvent inclure des tests, des examens, des projets finaux ou d’autres méthodes d’évaluation structurées.

La combinaison des évaluations formatives et sommatives offre une vue complète de l’efficacité de l’intervention d’apprentissage. Les évaluations formatives aident à guider le processus d’apprentissage en cours, tandis que les évaluations sommatives fournissent une évaluation finale de ce que les personnes apprenants ont appris et retenu.

Dans une approche d’apprentissage holistique, l’évaluation formative fournit des informations en temps réel qui peuvent être utilisées pour améliorer les stratégies d’enseignement et d’apprentissage, tandis que l’évaluation sommative peut aider à déterminer l’efficacité générale du programme et informer les futures décisions pédagogiques.

Pour les personnes professionnelless responsables de formation, l’intégration efficace des évaluations formatives et sommatives est essentielle. Cela permet non seulement de garantir que les groupes apprenants atteignent les résultats d’apprentissage souhaités, mais aussi d’affiner et d’améliorer continuellement les méthodes d’enseignement.

| Groupes apprenants Types d’évaluation | Quoi | Quand | Comment |

| Évaluation formative | Recueillir des preuves d’apprentissage Évaluer les défis auxquels les personnes apprenantes peuvent être confrontées | Au fur et à mesure que les personnes apprenantes parcourent les sections ou les étapes de l’expérience d’apprentissage | Activités collaboratives Discussions Jeux et autres |

| Évaluation sommative | Évaluer dans quelle mesure une personne apprenante a atteint les objectifs d’apprentissage | Après avoir terminé toutes les composantes d’un programme de formation | Kirkpatrick niveaux 2 & 3 LTEM niveaux 4, 5, 6 & 7 Philipps niveaux 2, 3, et autres |

Référence

Evaluation Thesaurus. (s. d.). Google Books. https://books.google.ca/books?id=koL0Fs_ZSvQC&pg=PA169&dq=%22when+the+cook+tastes%22+bob+stake&hl=en&sa=X&redir_esc=y#v=onepage&q&f=false

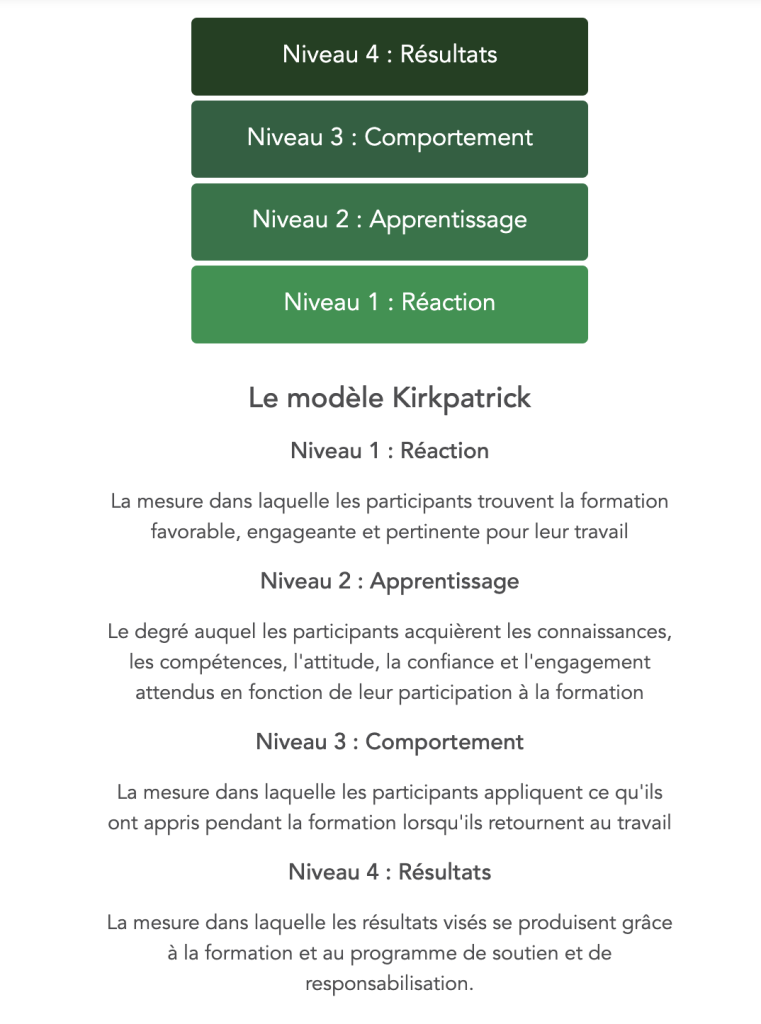

Le modèle de Kirkpatrick, élaboré par Donald Kirkpatrick dans les années 1950, est un cadre reconnu pour évaluer l’efficacité des programmes de formation. Il se compose de quatre niveaux : réaction, apprentissage, comportement, et résultats.

(What is the Kirkpatrick model ? / Kirkpatrick, 2022)

L’application de ce modèle permet une analyse complète de l’efficacité des formations. Au niveau réaction, l’équipe formatrice recueille des retours pour évaluer l’engagement et la satisfaction des personnes participantes. L’évaluation de l’apprentissage vérifie les connaissances et compétences acquises. Le comportemental scrute l’application des acquis en milieu professionnel. Enfin, le niveau des résultats mesure l’impact global sur l’organisation, incluant la productivité et la qualité.

Son adoption par les professionnelles et professionnels responsable de la formation est cruciale pour une évaluation exhaustive et pertinente. Le modèle de Kirkpatrick ne se limite pas à l’évaluation : il guide l’optimisation continue des programmes de formation, assurant une utilisation judicieuse des investissements en formation et contribuant à la réalisation des objectifs stratégiques de l’organisation.

Références et ressources complémentaires

Alliger, G. M., Tannenbaum, S. I., Bennett, W., Traver, H., & Shotland, A. (1997). A meta-analysis of the relations among training criteria. Personnel Psychology, 50(2), 341-358. https://onlinelibrary.wiley.com/doi/abs/10.1111/j.1744-6570.1997.tb00911.x

Bates, R. (2004). A critical analysis of evaluation practice: the Kirkpatrick model and the principle of beneficence. Evaluation and Program Planning, 27(3), 341-347. https://www.sciencedirect.com/science/article/abs/pii/S0149718904000369

Holton, E. F. III. (1996). The flawed four-level evaluation model. Human Resource Development Quarterly, 7(1), 5-21. https://onlinelibrary.wiley.com/doi/abs/10.1002/hrdq.3920070103

Kirkpatrick, D. L., & Kirkpatrick, J. D. (2006). Evaluating Training Programs: The Four Levels (3e éd.). Berrett-Koehler Publishers. https://www.bkconnection.com/books/title/evaluating-training-programs

Kirkpatrick free resources. (2023, 19 avril). Kirkpatrick Partners, LLC. https://www.kirkpatrickpartners.com/resources/

Phillips, J. J. (1996). How much is the training worth? Training and Development, 50(4), 20-24. https://eric.ed.gov/?id=EJ522494

What is the Kirkpatrick model ? / Kirkpatrick. (2022, 14 octobre). Kirkpatrick Partners, LLC. https://www.kirkpatrickpartners.com/the-kirkpatrick-model/

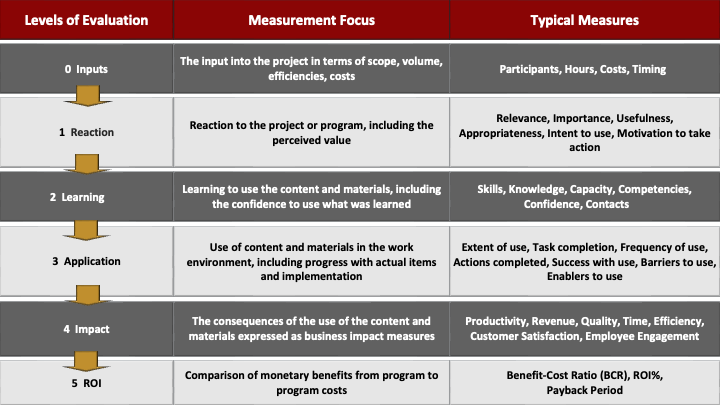

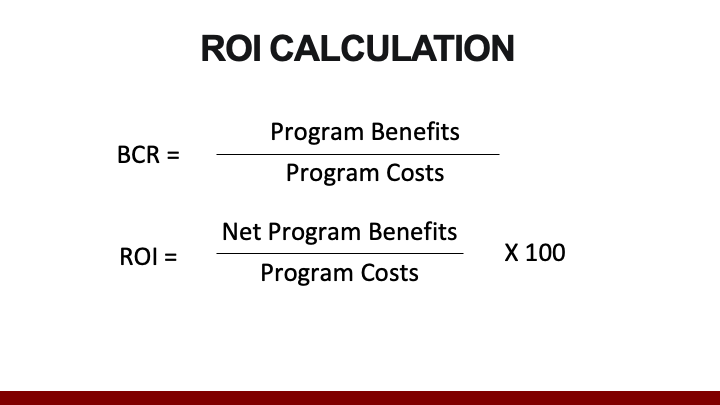

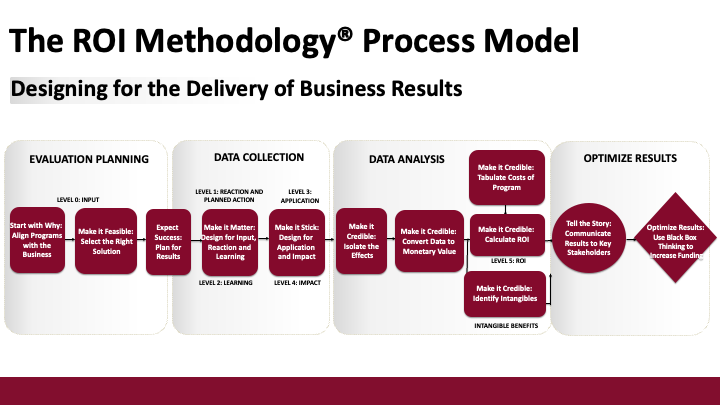

Le modèle de Phillips, élaboré par Jack Phillips, enrichit le modèle de Kirkpatrick en y ajoutant un cinquième niveau : le retour sur investissement (ROI). Ce niveau évalue l’efficacité économique des formations, comparant les bénéfices financiers obtenus après la formation aux coûts engagés. On calcule le ROI en convertissant les améliorations de performance, évaluées au quatrième niveau de Kirkpatrick, en gains financiers, puis en les mettant en perspective avec les dépenses totales de la formation (Phillips, 2003).

L’intégration du ROI offre une dimension financière essentielle à l’évaluation des formations, permettant aux groupes décideurs de mesurer l’impact économique de leurs investissements en formation. Cette approche implique d’identifier les coûts de formation, de mesurer les changements de performance liés, et de les convertir en valeurs monétaires.

Ce cinquième niveau répond à la nécessité de justifier les dépenses en formation, démontrant leur contribution non seulement au développement des compétences mais aussi à la santé financière de l’entreprise. Ceci aligne les programmes de formation avec les objectifs stratégiques de l’organisation.

Pour les personnes professionnels responsable de formation, le modèle de Phillips est un outil utile pour évaluer de façon exhaustive l’efficacité des programmes. Le ROI fournit des preuves tangibles de la valeur ajoutée de la formation, essentielles pour le soutien des parties prenantes et l’optimisation des ressources (Kirkpatrick & Kayser Kirkpatrick, 2016).

Le modèle ROI de Phillips comprend cinq niveaux :

- Réaction : Mesure la satisfaction des participants.

- Apprentissage : Évalue l’acquisition de connaissances et compétences.

- Application et Mise en œuvre : Analyse l’utilisation des acquis dans le milieu professionnel.

- Impact : Examine les effets de la formation sur les performances de l’entreprise.

- Retour sur Investissement : Compare les gains financiers de la formation à ses coûts.

Ce modèle offre une analyse complète et quantitative des formations, permettant une meilleure adéquation avec les objectifs stratégiques et une optimisation des investissements en formation.

(All roads lead to ROI : Demonstrate the ROT in HR, Learning, and Performance Improvement Programs, s. d.)

(All roads lead to ROI : Demonstrate the ROT in HR, Learning, and Performance Improvement Programs, s. d.)

(All roads lead to ROI : Demonstrate the ROT in HR, Learning, and Performance Improvement Programs, s. d.)

Références

All roads lead to ROI : Demonstrate the ROT in HR, Learning, and Performance Improvement Programs. (s. d.). [Diapositives]. ROI Institute. https://www.roiinstituteacademy.com/products/tools-and-resources/categories/923254/posts/3069603

Kirkpatrick, D. L., & Kayser Kirkpatrick, J. (2016). Kirkpatrick’s four levels of training evaluation. ATD Press. https://www.td.org/books/kirkpatricks-four-levels-of-training-evaluation-new

Phillips, J.J. (1999). HRD Trends Worldwide : Shared solutions to compete in a global economy. Boston, MA, Butterworth–Heinemann. https://eric.ed.gov/?id=ED441988

Phillips, J.J. (2003). Return on investment in Training and Performance improvement. Improving Human Performance series. https://www.academia.edu/67845494/Jack_J_Phillips_Return_on_Investment_in_Training_and_Performance_Improvement_Programs_Second_Edition_Improving_Human_Performance

ROI Institute. (s. d.). Consulté le 9 décembre 2023, à l’adresse https://roiinstitute.net/

Le modèle des trois niveaux de performance développé par Rummler et Brache est un cadre conceptuel reconnue pour son efficacité dans l’amélioration de la performance organisationnelle (Rummler, 1996; Rummler, 2007; Rummler & Brache, 2012). Cette approche se concentre sur trois niveaux d’analyse principaux : organisationnel, processus et emploi, chacun jouant un rôle crucial dans la performance globale.

Les trois Niveaux d’Analyse dans l’Approche de Rummler et Brache :

- Niveau Organisationnel : À ce niveau, l’analyse se concentre sur l’interaction globale entre l’organisation et son marché. Cela inclut l’examen des macro-systèmes et des structures fondamentales, ainsi que la manière dont l’organisation atteint ses objectifs stratégiques (Rummler, 1996). Les variables à ce niveau affectent les performances à travers la stratégie globale et la réalisation des objectifs. Une analyse approfondie à ce niveau permet de comprendre comment les différentes fonctions de l’organisation s’intègrent pour atteindre les buts fixés.

- Niveau du Processus : Au niveau des processus, l’accent est mis sur les manières dont l’organisation produit ses résultats à travers des processus de travail interfonctionnels. Ces processus peuvent inclure la conception de nouveaux produits, la production, la vente, la distribution, etc. (Rummler & Brache, 2012). L’efficacité d’une organisation est directement liée à la qualité de ses processus. L’analyse à ce niveau vise à s’assurer que les processus répondent aux besoins de la clientèle et fonctionnent efficacement, avec des objectifs et des mesures définis selon les exigences de la clientèle et de l’organisation.

- Niveau d’Emploi : Enfin, au niveau de l’emploi, l’analyse se concentre sur la façon dont les individus exécutent et gèrent les processus. Cela inclut l’examen de l’embauche, de la promotion, des responsabilités, des normes de performance, des retours d’information, des récompenses et de la formation (Rummler, 1996). Les performances individuelles sont cruciales pour l’exécution efficace des processus et, par conséquent, pour la réussite globale de l’organisation.

L’approche de Rummler et Brache rappelle aux personnes professionnelles ayant des responsabilités de formation que pour améliorer la performance organisationnelle, il est essentiel de considérer l’organisation des structures dans son ensemble, y compris ses processus et le personnel. En se concentrant sur ces trois niveaux, l’analyse du rendement stratégique vise à créer un alignement entre la stratégie de l’organisation, ses processus opérationnels, et les performances individuelles, conduisant ainsi à une amélioration globale de l’efficacité et de l’efficience (Rummler & Brache, 2012; Rummler, 1996). Cette méthode est adaptée à de nombreux secteurs, y compris le secteur manufacturier, les services financiers, et l’éducation. Elle aide les organisations à comprendre et à optimiser leurs processus internes et la performance individuelle en alignant les stratégies et les objectifs opérationnels (Rummler, 2007).

Rummler-Brache Performance™ Matrix (RummlerBrache.com, s. d.)

Rummler-Brache Performance™ Matrix (RummlerBrache.com, s. d.)

Rummler-Brache key metrics(RummlerBrache.com, s. d.)

Références et ressources complémentaires

Free process improvement mapping tools. (s. d.). RummlerBrache.com. https://www.rummlerbrache.com/process-improvement-mapping-tools

Overview of Rummler-Brache concepts. (s. d.). RummlerBrache.com. https://www.rummlerbrache.com/the-three-levels-of-performance

RummlerBrache.com. (s. d.). RummlerBrache.com. https://www.rummlerbrache.com/

Rummler, G.A. (1996). In search of the holy performance grail. Training & Development, 50(4), 26‑33. https://eric.ed.gov/?id=EJ522495

Rummler, G. A. (2007). Serious Performance Consulting According to Rummler. John Wiley & Sons. https://www.abebooks.fr/9780787996161/Serious-Performance-Consulting-Rummler-Geary-0787996165/plp

Rummler, G. A., & Brache, A. P. (2012). Improving Performance : How to Manage the White Space on the Organization Chart. John Wiley & Sons. https://www.perlego.com/book/1012351/improving-performance-how-to-manage-the-white-space-on-the-organization-chart-pdf

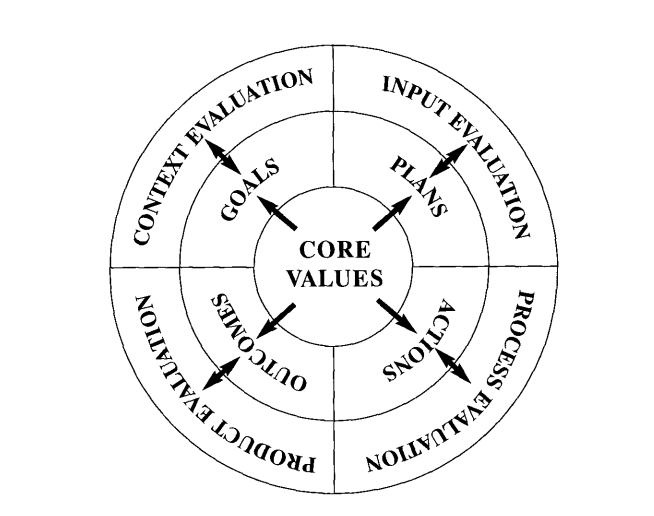

Le modèle CIPP, conçu par Daniel Stufflebeam dans les années 1960, est un cadre exhaustif pour l’évaluation des programmes éducatifs et de formation. Ce modèle s’articule autour de quatre composantes clés : contexte, intrant, processus, et produit, chacune jouant un rôle crucial dans l’évaluation complète d’un programme.

- Évaluation du Contexte : Cette composante examine l’environnement dans lequel le programme est mis en place. Elle évalue les besoins, problèmes et attentes des groupes cibles, essentielle pour déterminer la pertinence du programme par rapport aux besoins de sa population cible.

- Évaluation de l’Intrant : Cette phase se concentre sur les ressources, stratégies et plans utilisés. Elle vérifie si les ressources allouées sont adéquates et appropriées pour atteindre les objectifs du programme, garantissant ainsi une conception et une préparation efficaces.

- Évaluation du Processus : Cette étape apprécie la mise en œuvre effective du programme. Elle s’intéresse aux activités, procédures et interactions durant le programme, permettant le suivi et l’ajustement en temps réel pour assurer que les activités contribuent efficacement aux objectifs.

- Évaluation du Produit : La dernière composante mesure les résultats du programme, analysant les effets à court et long terme sur les personnes participantes et évaluant la réalisation des objectifs. Cette évaluation fournit des informations cruciales sur l’efficacité et l’impact du programme, se concentrant sur les résultats tangibles et mesurables.

Le modèle CIPP offre une analyse holistique et méthodique dans l’évaluation des programmes de formation. L’évaluation du contexte assure l’alignement du programme avec les besoins spécifiques des groupes apprenants. L’évaluation de l’intrant examine la correspondance entre les ressources/plans et les objectifs du programme. L’évaluation du processus permet un suivi et une amélioration continus de la mise en œuvre, tandis que l’évaluation du produit fournit des données sur l’efficacité du programme et son impact sur les personnes participantes.

Le modèle CIPP est indispensable pour l’amélioration continue des programmes de formation. Il guide les personnes professionnels en charge de la formation dans l’identification des domaines d’amélioration, favorisant des décisions éclairées pour augmenter la qualité et l’efficacité. Cette approche proactive renforce la pertinence, l’efficacité et l’impact des programmes, aidant à comprendre les facteurs de succès et d’échec, et maximisant ainsi l’impact de la formation.

Les éléments clés du modèle d’évaluation du CIPP et les relations associées avec les programmes (Stufflebeam, 2003)

Références

Stufflebeam, D. L. (2003). The CIPP Model for Evaluation. International Handbook of Educational Evaluation (pp. 31-62). Springer, Dordrecht. https://beckassets.blob.core.windows.net/product/readingsample/336182/9781402008498_excerpt_003.pdf

Stufflebeam, D. L., & Zhang, G. (2017). The CIPP Evaluation Model: How to Evaluate for Improvement and Accountability. https://www.routledge.com/The-CIPP-Evaluation-Model-How-to-Evaluate-for-Improvement-and-Accountability/Stufflebeam-Zhang/p/book/9781462529230

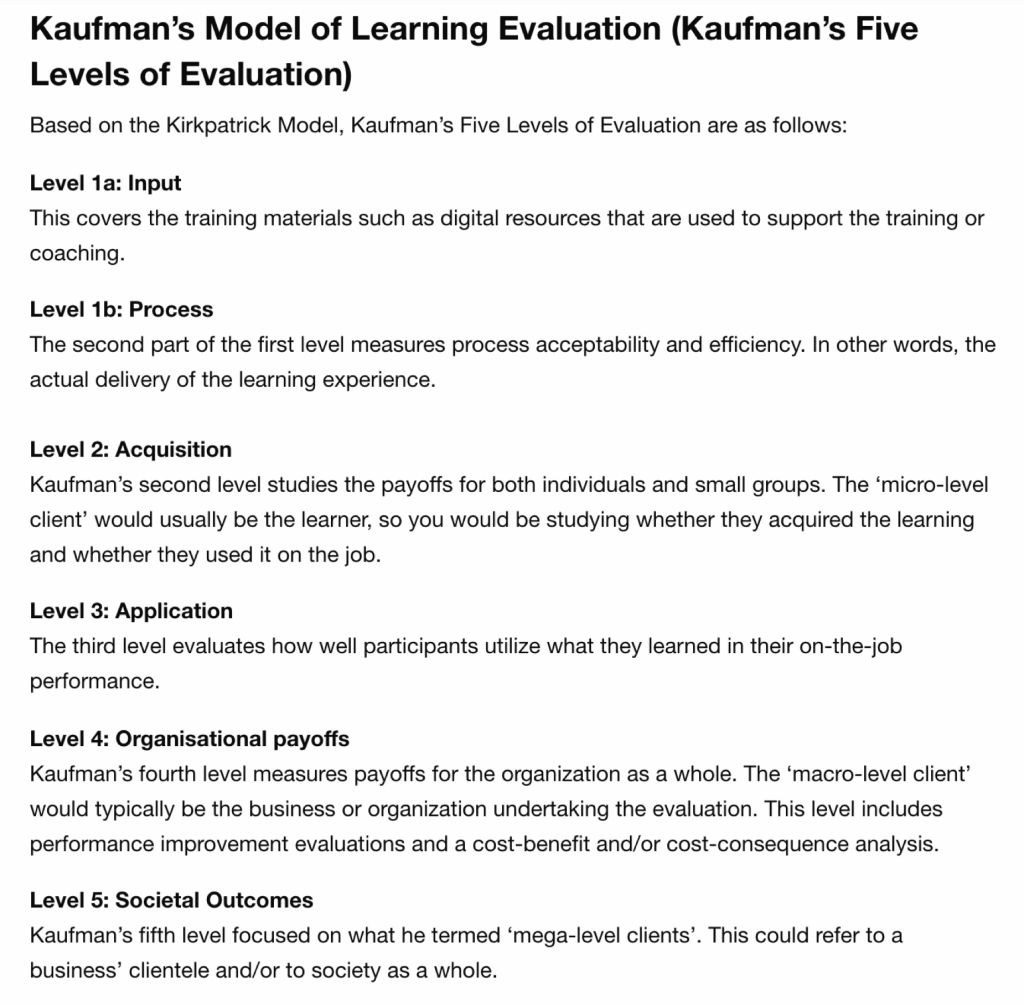

Le modèle de Kaufman, développé par Roger Kaufman, est une extension et une réaction au modèle de Kirkpatrick, et il propose une approche méthodique pour évaluer l’efficacité des programmes de formation. Ce modèle se distingue par sa structure en cinq niveaux, qui visent à évaluer l’impact des formations de manière complète, allant au-delà des gains individuels pour inclure des bénéfices collectifs et organisationnels.

- Input (Niveau 1a) : Ce niveau concerne la qualité et la disponibilité des ressources de formation, comme les supports et outils numériques utilisés pour soutenir l’expérience d’apprentissage.

- Process (Niveau 1b) : Ici, l’accent est mis sur l’acceptabilité et l’efficacité du processus de formation lui-même, c’est-à-dire la livraison réelle de l’expérience d’apprentissage.

- Acquisition (Micro niveau) : Ce niveau se concentre sur les bénéfices individuels et en petits groupes. Il évalue si les apprenants ont acquis les connaissances ou compétences et si elles sont appliquées sur le lieu de travail.

- Application (Micro niveau) : Ce niveau évalue l’utilisation effective des connaissances et compétences apprises dans la performance professionnelle des participants.

- Organizational Payoffs (Macro niveau) : Ici, l’impact de la formation sur l’organisation dans son ensemble est mesuré, y compris l’amélioration des performances et une analyse coût-bénéfice.

- Societal Outcomes (Mega niveau) : Le cinquième niveau de Kaufman s’intéresse aux bénéfices pour la société dans son ensemble ou pour la clientèle d’une entreprise.

(Kaufman’s Model of Learning Evaluation : Key Concepts and tutorial, s. d.)

Le modèle de Kaufman diffère de celui de Kirkpatrick en divisant le premier niveau de Kirkpatrick en deux (Input et Process) et en ajoutant un cinquième niveau pour évaluer les résultats pour la société et les clients. Ce modèle va au-delà de la simple évaluation de la livraison de formation et considère également l’impact de la formation.

Au niveau organisationnel, le modèle se concentre sur l’alignement de la formation avec les objectifs stratégiques de l’organisation, évaluant son impact sur la performance organisationnelle. À l’échelle de l’équipe ou du groupe, il examine comment la formation affecte la collaboration, la communication et la performance collective. Enfin, au niveau individuel, l’accent est mis sur l’amélioration des compétences, des connaissances et des attitudes des personnes participantes.

Cette approche holistique est essentielle pour les personnes professionnelles responsable de formation, car elle permet une évaluation exhaustive et stratifiée des programmes de formation. Elle assure l’alignement des programmes de formation avec les besoins et objectifs de l’organisation à tous les niveaux, démontrant ainsi leur valeur ajoutée.

Néanmoins, certains aspects du modèle de Kaufman, en particulier l’évaluation des conséquences sociétales, peuvent s’avérer moins pratiques en raison des difficultés à obtenir des données robustes. Pour une utilisation plus pragmatique, il est recommandé de considérer le modèle de Kaufman comme ayant six niveaux, en supprimant la terminologie mega/macro/micro, pour une meilleure clarté et applicabilité.

Références

Kaufman, R. (1998). Strategic Planning Plus: An Organizational Guide. Sage Publications. https://sk.sagepub.com/books/strategic-planning-plus

Kaufman, R., & Guerra-López, I. (2013). Needs Assessment for Organizational Success. ASTD Press. https://www.td.org/books/needs-assessment-for-organizational-success

Kaufman’s Model of Learning Evaluation : Key Concepts and tutorial. (s. d.). https://kodosurvey.com/blog/kaufmans-model-learning-evaluation-key-concepts-and-tutorial

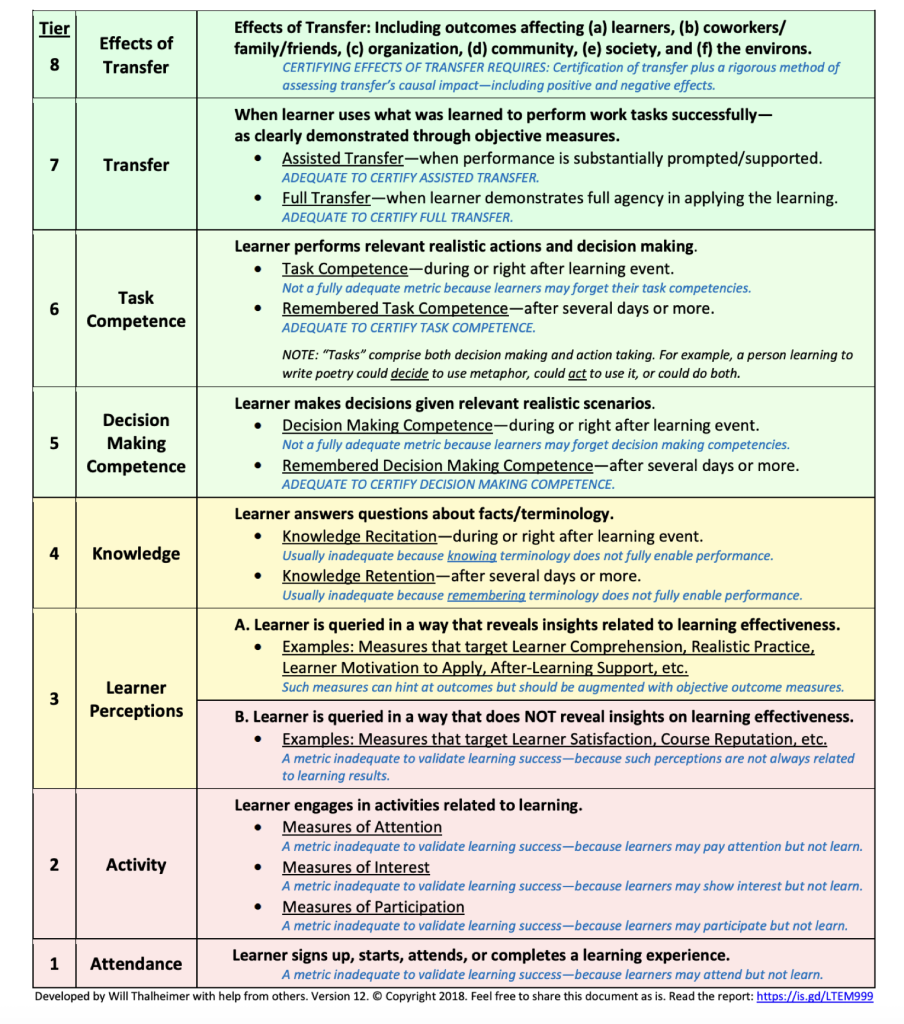

Le Learning-Transfer Evaluation Model (LTEM), développé par Will Thalheimer, est un cadre conçu pour évaluer les résultats d’apprentissage et de formation. Le modèle est structuré en huit niveaux, chacun représentant un stade d’efficacité de l’apprentissage, allant des résultats les moins efficaces aux plus efficaces.

(Work-Learning Research, Inc., 2023)

- Niveau 1 – Présence : Ce niveau évalue simplement la participation ou l’assiduité à une formation ou un programme d’apprentissage.

- Niveau 2 – Activité : À ce stade, l’évaluation porte sur l’engagement des apprenants dans les activités d’apprentissage, sans nécessairement mesurer l’apprentissage effectif.

- Niveau 3 – Attention : Ici, l’accent est mis sur le degré d’attention ou d’intérêt des apprenants, mesurant leur implication mentale pendant le processus d’apprentissage.

- Niveau 4 – Préférence : Ce niveau évalue les réactions et les préférences des apprenants, souvent à travers des enquêtes de satisfaction.

- Niveau 5 – Connaissance : À ce stade, l’évaluation mesure les connaissances acquises ou les compétences développées à la suite de la formation.

- Niveau 6 – Décision : Ce niveau concerne la capacité des apprenants à prendre des décisions ou à appliquer un jugement basé sur les connaissances ou compétences acquises.

- Niveau 7 – Action : Ici, l’accent est mis sur l’application des compétences ou connaissances dans des situations réelles ou simulées.

- Niveau 8 – Effets : Le niveau le plus élevé mesure l’impact de l’apprentissage sur les performances réelles sur le lieu de travail ou dans la vie quotidienne, ainsi que ses effets à plus long terme.

Le LTEM se distingue des modèles d’évaluation traditionnels en mettant l’accent sur les résultats concrets et l’application pratique de l’apprentissage. Il vise à fournir une compréhension plus profonde et plus holistique de l’efficacité des programmes d’apprentissage et de formation. Les niveaux indiqués en vert sont consédérés à générer les résultats les plus utiles.

Référence

Work-Learning Research, Inc. (2023, 4 juillet). LTEM & # 187 ; Work-Learning Research. Work-Learning Research. https://www.worklearning.com/LTEM/

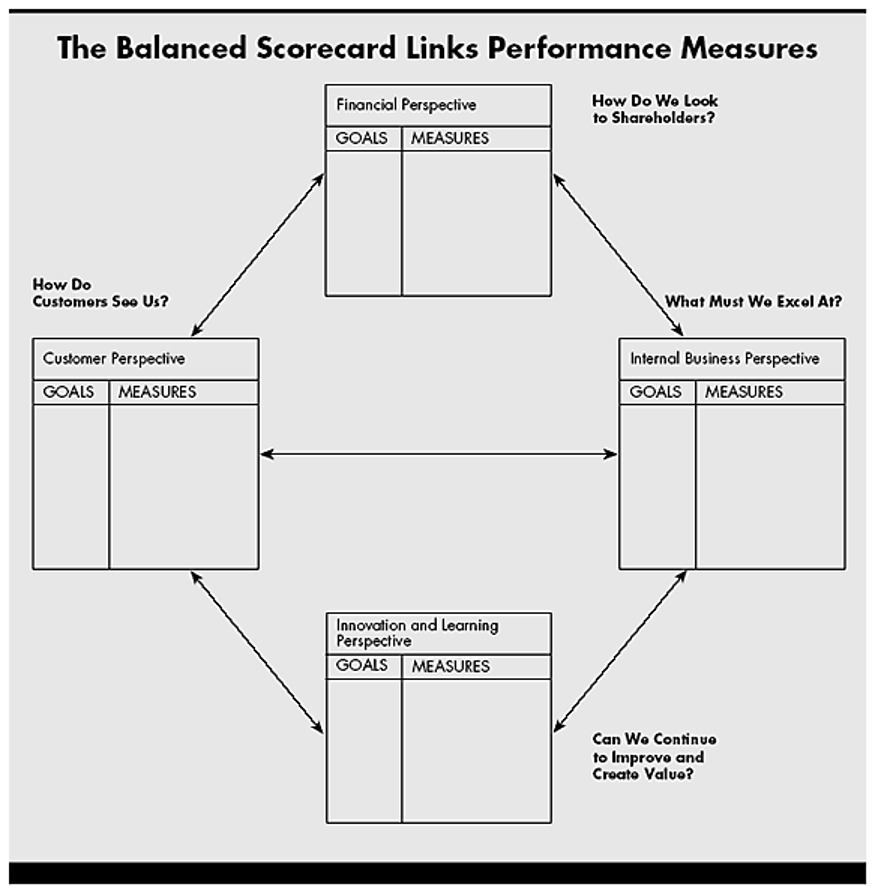

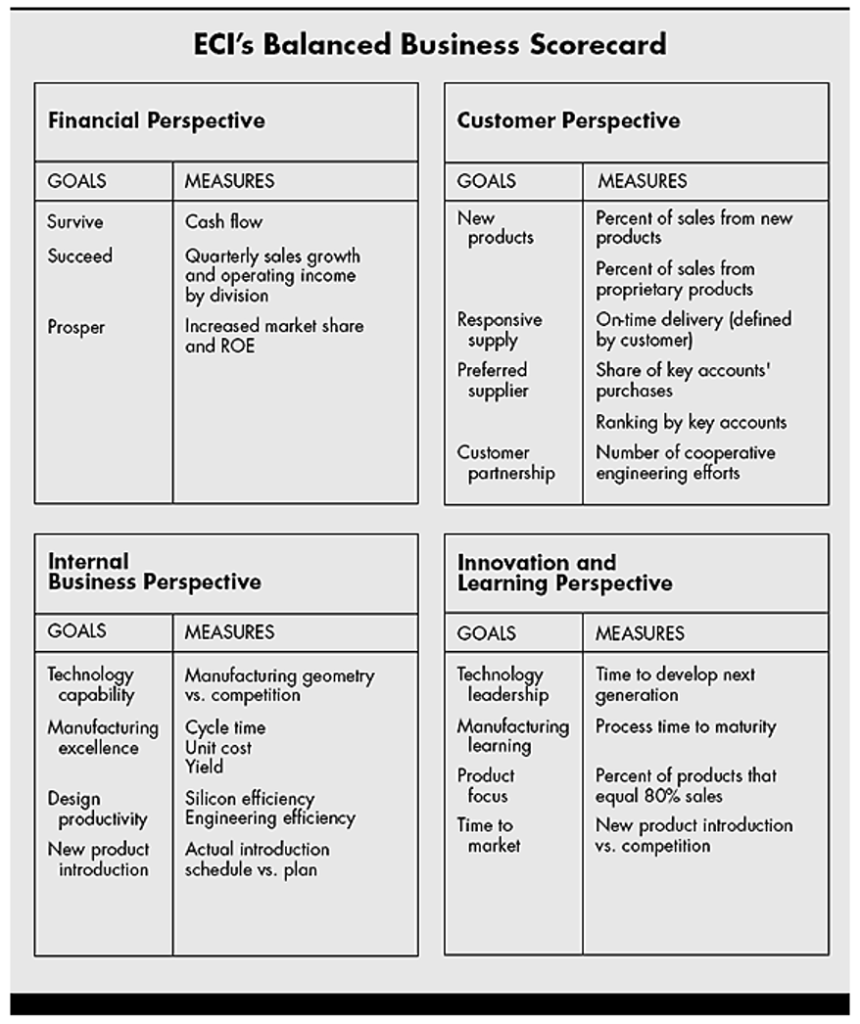

Le Balanced Scorecard (BSC), développé par Robert S. Kaplan et David P. Norton dans les années 1990, est un cadre stratégique utilisé pour le suivi de la performance organisationnelle. Il intègre des mesures financières et non financières réparties en quatre perspectives : financière, clientèle, processus internes, et apprentissage et croissance. L’objectif du BSC est de fournir une vision équilibrée et complète de la performance de l’organisation, en allant au-delà des indicateurs financiers traditionnels pour inclure des facteurs clés de succès à long terme (Kaplan & Norton, 1992).

La perspective financière évalue la performance économique de l’organisation et son impact sur les actionnaires et actionnaires. La perspective clientèle se concentre sur la satisfaction et la fidélité de la clientèle, un indicateur essentiel de la performance commerciale future. La perspective des processus internes examine l’efficacité et l’efficience des processus opérationnels. Enfin, la perspective apprentissage et croissance évalue la capacité de l’organisation à innover, à améliorer et à apprendre, ce qui est crucial pour sa viabilité à long terme (Kaplan & Norton, 1992).

L’utilisation du Balanced Scorecard permet aux organisations de lier leurs objectifs stratégiques à des indicateurs de performance spécifiques. Cela aide à aligner les activités opérationnelles avec la stratégie globale et à surveiller les progrès vers la réalisation des objectifs stratégiques. Le BSC encourage également une réflexion stratégique et une prise de décision basée sur une gamme complète d’informations de performance (Kaplan & Norton, 1992).

Pour une personne responsable de formation, l’intégration du Balanced Scorecard dans la planification et l’évaluation des programmes de formation est particulièrement pertinente. En utilisant le BSC, il est possible de relier les initiatives de formation aux objectifs stratégiques de l’organisation et de mesurer leur impact sur la performance globale. Cela permet non seulement de justifier les investissements en formation, mais aussi d’assurer que les programmes de formation contribuent de manière significative aux objectifs à long terme de l’organisation.

(Kaplan & Norton,1992)

(Kaplan & Norton,1992)

Référence

Kaplan, R. S., & Norton, D. P. (1992). The Balanced Scorecard – Measures That Drive Performance. Harvard Business Review. https://hbr.org/1992/01/the-balanced-scorecard-measures-that-drive-performance-2

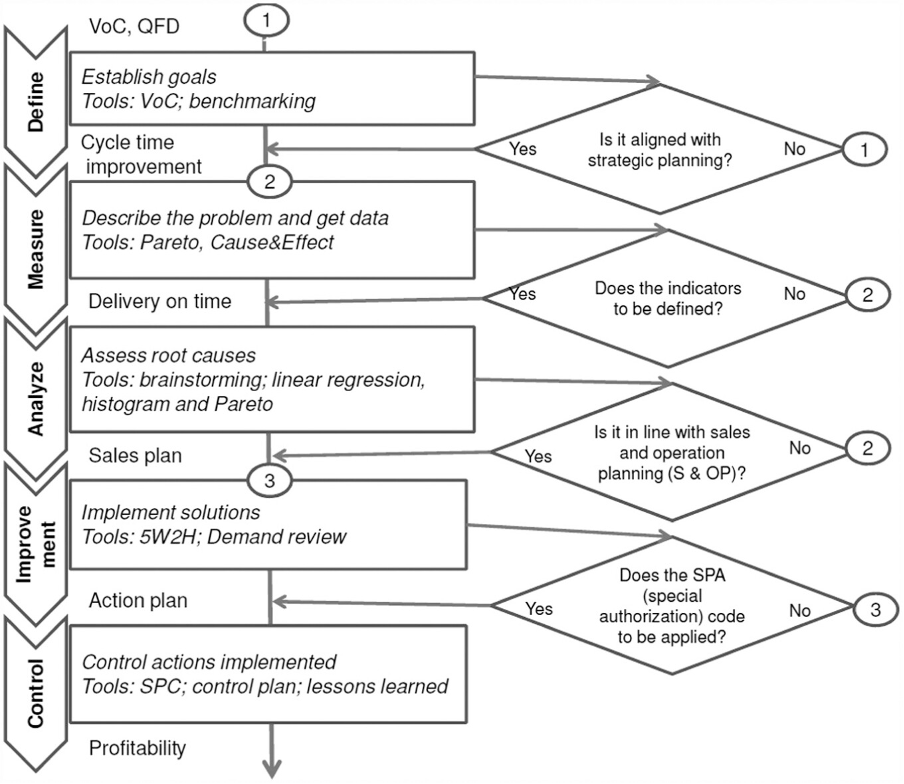

Six Sigma est une méthodologie de gestion de la qualité axée sur l’utilisation de données et de statistiques pour améliorer les processus et la qualité dans les organisations. Développée à l’origine par Motorola dans les années 1980 et popularisée par General Electric dans les années 1990, Six Sigma vise à réduire la variabilité des processus et à éliminer les défauts pour améliorer la performance globale de l’entreprise. La méthodologie utilise un ensemble d’outils et de techniques statistiques pour identifier et éliminer les causes des défauts et des variations dans les processus de fabrication et d’affaires (Harry & Schroeder, 2000).

Six Sigma est structuré autour de deux cadres principaux : DMAIC (Définir, Mesurer, Analyser, Innover, Contrôler) pour l’amélioration des processus existants, et DMADV (Définir, Mesurer, Analyser, Concevoir, Vérifier) pour le développement de nouveaux produits ou processus.

- DMAIC se concentre sur l’identification des problèmes dans les processus existants, la mesure de la performance actuelle, l’analyse des causes profondes des problèmes, l’amélioration des processus et le contrôle pour maintenir les gains de performance.

- DMADV, quant à lui, est utilisé pour développer de nouveaux processus ou produits à un niveau de qualité Six Sigma (Harry & Schroeder, 2000).

L’approche Six Sigma met l’accent sur la prise de décision basée sur des données et des faits. Elle vise à créer une culture d’amélioration continue et d’excellence opérationnelle. Les organisations qui adoptent Six Sigma cherchent souvent à atteindre un niveau de qualité où le nombre de défauts est réduit à près de 3,4 défauts par million d’opportunités, ce qui représente un niveau de performance extrêmement élevé (Harry & Schroeder, 2000).

Pour les personnes responsables de formation, l’intégration de la méthodologie Six Sigma dans les programmes de formation peut être extrêmement bénéfique. Elle permet de développer des compétences en matière d’analyse de données, de résolution de problèmes et d’amélioration des processus auprès du personnel. La formation Six Sigma peut également contribuer à l’instauration d’une culture d’amélioration continue et d’excellence dans la qualité, alignée sur les objectifs stratégiques de l’organisation.

The Six Sigma framework (Takao et al., 2017)

Références

Harry, M., & Schroeder, R. (2000). Six Sigma: The Breakthrough Management Strategy Revolutionizing the World’s Top Corporations. Currency. https://books.google.ca/books/about/Six_Sigma.html?id=RY0rAAAAYAAJ&redir_esc=y

Takao, M. R. V., Woldt, J., & Da Silva, Í. B. (2017). Six SIGMA Methodology Advantages for small- and medium-sized Enterprises : A case study in the plumbing industry in the United States. Advances in Mechanical Engineering, 9(10), 168781401773324. https://doi.org/10.1177/1687814017733248

Le feedback à 360 degrés est un processus d’évaluation du personnel où un employé ou une employée reçoit des retours confidentiels et anonymes de diverses sources autour de lui ou d’elle, notamment des supérieurs, des collègues, des subordonnés et parfois même des clients. Cette méthode vise à fournir une perspective complète sur les performances et les compétences d’un individu en recueillant des opinions de différentes personnes qui interagissent avec lui ou elle dans divers contextes professionnels. Il est crucial que les retours soient anonymes pour garantir l’honnêteté et la franchise des personnes participantes, et l’assurance de la confidentialité est essentielle pour maintenir la confiance dans le processus. Le feedback à 360 degrés est souvent utilisé pour le développement personnel, l’amélioration des compétences de leadership et la planification de la carrière (Bracken, Timmreck, & Church, 2001).

L’un des principaux avantages du feedback à 360 degrés est qu’il offre une vision plus équilibrée et objective des performances d’un employé ou d’une employée. Contrairement aux évaluations traditionnelles, qui peuvent être influencées par la subjectivité ou les biais du superviseur ou de la superviseure, le feedback à 360 degrés intègre divers points de vue, réduisant ainsi le risque de partialité. Cela permet aux employés et employées de comprendre comment leurs actions et comportements sont perçus par différents membres de l’organisation (Bracken, Timmreck, & Church, 2001).

Le feedback à 360 degrés peut également jouer un rôle important dans le développement des compétences de communication des personnes employées, car il les encourage à être réceptifs aux retours d’autrui.