Les « deepfakes » : Comment donner aux jeunes les moyens de lutter contre la menace de la désinformation et des fausses informations ?

Le Global Risks Report 2024 du Forum économique mondial a lancé un avertissement sévère : la désinformation et la mésinformation, principalement alimentées par les deepfakes, sont classées comme les risques mondiaux à court terme les plus graves auxquels le monde sera confronté au cours des deux prochaines années.

En octobre 2023, le Conseil de l’innovation du Québec a partagé le même constat après des mois de consultations auprès d’experts et du public.

Cette tromperie numérique, qui exploite l’intelligence artificielle et, plus récemment, l’IA générative, pour créer des fabrications hyperréalistes, va au-delà d’une merveille technologique ; elle constitue une profonde menace sociétale.

En réponse au manque d’efficacité de la technologie et de la législation dans la lutte contre les deepfakes, un projet de recherche mené par mon équipe et moi-même met en lumière une solution vitale : l’intervention humaine par le biais de l’éducation.

Les solutions technologiques ne suffisent pas

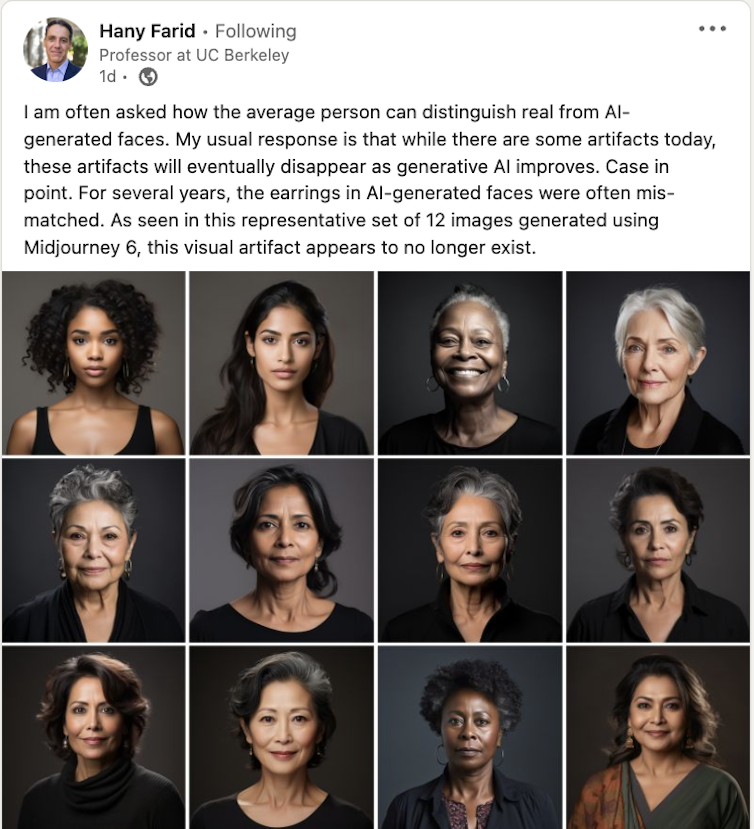

Malgré le développement continu d’outils de détection des « deepfakes », ces solutions technologiques ont du mal à rattraper les capacités de progression rapide des algorithmes de « deepfake ».

Les systèmes juridiques et les gouvernements s’efforcent de suivre le rythme de cette évolution rapide de la tromperie numérique.

Il est urgent que l’éducation adopte une approche plus sérieuse, plus agressive et plus stratégique pour préparer les jeunes à lutter contre cette menace imminente.

Inquiétudes liées à la désinformation politique

Le potentiel de polarisation politique est particulièrement alarmant.

Près de trois milliards de personnes devraient voter dans des pays comme le Bangladesh, l’Inde, l’Indonésie, le Mexique, le Pakistan, le Royaume-Uni et les États-Unis au cours des deux prochaines années.

Les campagnes de désinformation menacent de saper la légitimité des gouvernements nouvellement élus.

Des « deepfakes » de personnalités de premier plan, comme le mannequin américain d’origine palestinienne Bella Hadid et d’autres, ont été manipulés pour falsifier leurs déclarations politiques, ce qui illustre la capacité de la technologie à influencer l’opinion publique et à fausser les récits politiques.

Un deepfake de Greta Thunberg plaidant pour des « grenades végétaliennes » illustre l’utilisation néfaste de cette technologie.

La présentation par Meta d’un assistant d’intelligence artificielle à l’effigie de célébrités suscite des inquiétudes quant à son utilisation abusive et à la diffusion de la désinformation.

Fraude financière, préjudices pornographiques

Les vidéos « deepfake » sont aussi, sans surprise, utilisées pour commettre des fraudes financières.

Le célèbre YouTubeur MrBeast s’est fait passer pour un deepfake sur TikTok, promettant faussement un iPhone 15 à gagner, ce qui a conduit à une escroquerie financière.

Ces incidents mettent en évidence la vulnérabilité à des fraudes et escroqueries sophistiquées basées sur l’IA et visant des personnes de tous âges.

La pornographie « deepfake » représente une grave préoccupation pour les jeunes comme pour les adultes, car les visages des personnes sont superposés sans consentement à des contenus explicites. Des images deepfake sexuellement explicites de Taylor Swift se sont répandues sur les médias sociaux avant que les plateformes ne les retirent. L’une d’entre elles a été visionnée plus de 45 millions de fois.

Approches politiques et technologiques

La politique de Meta oblige désormais les annonceurs politiques à divulguer toute manipulation de l’IA dans les publicités, une décision reprise par Google.

Neil Zhang, doctorant à l’université de Rochester, développe des outils de détection des deepfakes audio, notamment des algorithmes avancés et des techniques de filigrane.

Les États-Unis ont introduit plusieurs lois : le Deepfakes Accountability Act of 2023, le No AI FRAUD Act protégeant les identités contre l’utilisation abusive de l’IA et le Preventing Deepfakes of Intimate Images Act ciblant les deepfakes pornographiques non consensuels.

Au Canada, les législateurs ont proposé le projet de loi C-27 et la loi sur l’intelligence artificielle et les données (AIDA) qui mettent l’accent sur la transparence de l’IA et la confidentialité des données. La vidéo « La désinformation peut causer des dommages » du Centre de la sécurité des télécommunications (CST), une agence fédérale canadienne consacrée à la sécurité et au renseignement.

Le Royaume-Uni a adopté son projet de loi sur la sécurité en ligne. L’UE a récemment annoncé un accord provisoire concernant sa loi sur l’IA ; la directive de l’UE sur la responsabilité en matière d’IA aborde des questions plus larges de sécurité en ligne et de réglementation de l’IA.

Le gouvernement indien a annoncé son intention d’élaborer une réglementation visant à lutter contre les « deepfakes ».

Ces mesures reflètent l’engagement croissant de la communauté internationale à lutter contre les effets pernicieux des « deepfakes ». Toutefois, ces efforts ne suffisent pas à contenir, et encore moins à stopper, la prolifération des deepfakes.

Étude de recherche avec des jeunes

La recherche que j’ai menée avec des collègues, financée par le Conseil de recherches en sciences humaines (CRSH) et Patrimoine canadien, révèle comment l’autonomisation des jeunes avec une agence numérique peut être une force contre la marée montante de la désinformation alimentée par les technologies de deepfake et d’intelligence artificielle.

Notre étude s’est concentrée sur la façon dont les jeunes perçoivent l’impact des deepfakes sur des questions critiques et sur leur propre processus de construction de connaissances dans des contextes numériques. Nous avons exploré leur capacité et leur volonté de contrebalancer efficacement la désinformation. L’auteure Nadia Naffi partage certains résultats d’une étude sur l’agence numérique des jeunes et les « deepfakes ».

L’étude a réuni des étudiants universitaires canadiens, âgés de 18 à 24 ans, pour une série d’ateliers pratiques, d’entretiens individuels approfondis et de discussions de groupe.

Les participants ont créé des « deepfakes », ce qui leur a permis d’acquérir une compréhension directe de la facilité d’accès et d’utilisation de cette technologie et de son potentiel d’utilisation abusive. Cet apprentissage par l’expérience s’est avéré inestimable pour démystifier la facilité avec laquelle les « deepfakes » sont générés.

Les participants ont d’abord perçu les deepfakes comme un élément incontrôlable et inévitable du paysage numérique.

Grâce à l’engagement et à la discussion, ils sont passés du statut de spectateurs passifs des deepfakes à une prise de conscience plus profonde de la gravité de la menace qui pèse sur eux. Ils ont également développé un sens de la responsabilité dans la prévention et l’atténuation de la propagation des deepfakes, ainsi qu’une volonté de contrer les deepfakes.

Les élèves ont formulé des recommandations d’actions concrètes, notamment en exhortant les systèmes éducatifs à responsabiliser les jeunes et à les aider à prendre conscience que leurs actions peuvent faire la différence. Cela inclut :

- enseigner les effets néfastes de la désinformation sur la société ;

- offrir aux jeunes des espaces de réflexion et de remise en question des normes sociétales, les informer sur les politiques relatives aux médias sociaux et définir les contenus autorisés et interdits ;

- former les élèves à reconnaître les « deepfakes » en les exposant à la technologie qui les sous-tend ;

- encourager l’engagement dans des causes importantes tout en restant attentif à la désinformation et en aidant les jeunes à contrer la désinformation de manière respectueuse et productive.

Nécessité d’une stratégie à multiples facettes

Sur la base de nos recherches et des recommandations des participants, nous proposons une stratégie à multiples facettes pour lutter contre la prolifération des « deepfakes ».

L’éducation aux « deepfakes » doit être intégrée dans les programmes d’enseignement, tout en encourageant la pensée critique et l’action numérique chez nos jeunes. Les jeunes doivent être encouragés à participer activement, mais en toute sécurité, bien informés et de manière stratégique, à la lutte contre les « deepfakes » malveillants dans les espaces numériques.

Nous insistons sur l’importance des expériences d’apprentissage pratiques et collaboratives. Nous plaidons également en faveur d’une approche éducative interdisciplinaire qui associe la technologie, la psychologie, l’étude des médias et l’éthique afin d’appréhender pleinement les implications des « deepfakes ».

L’élément humain

Notre recherche met en évidence une constatation cruciale : L’élément humain, en particulier le rôle de l’éducation, est indispensable dans la lutte contre les « deepfakes ». Nous ne pouvons pas compter uniquement sur la technologie et les solutions juridiques.

En dotant les jeunes générations, mais aussi chaque membre de notre société, des compétences nécessaires pour analyser de manière critique et remettre en question la désinformation, nous favorisons l’émergence d’une société maîtrisant le numérique et suffisamment résiliente pour résister au pouvoir de manipulation des « deepfakes ».

Pour ce faire, nous devons donner aux gens les moyens de comprendre qu’ils ont un rôle à jouer et qu’ils peuvent agir pour préserver l’intégrité de notre monde numérique.

Autrice

Cet article a été publié dans La Conversation Canada par Nadia Naffi.